Interpretando el NVIDIA GeForce RTX 2080

Reflexionamos sobre lo que supone la nueva arquitectura de NVIDIA y cómo cambiará el futuro de los videojuegos.

Como cada nueva generación de procesadores gráficos llega el momento de medir variables como su potencia, innovación o rendimiento. Así lo llevamos haciendo desde las primeras 3dfx Voodoo y Riva 128, sin excepción; hasta hoy. No podemos analizar estas 2080. Al menos no creemos que sea posible hacerlo de una forma honesta y coherente. Por las razones que a continuación veremos, desistimos de plantear un análisis ordinario, con sus tablas de especificaciones, número de procesadores, de operaciones por segundo y la esperada comparativa de rendimiento con procesadores anteriores. Hacerlo hoy día no tiene sentido. No obstante, el que no podamos valorar lo que hoy nos ofrece NVIDIA no impide que interpretemos qué pueden y quieren ofrecer. De eso trata este artículo.

Que esta generación iba a ser distinta lo advertimos con las primeras filtraciones de especificaciones, previas al lanzamiento, muy alejadas de lo que cabría esperar en un salto de generación. Se mantuvo esa sensación extraña de que algo raro estaba pasando cuando en la presentación oficial en Colonia, cuando Jensen Huang, fundador y CEO de NVIDIA se pasó una hora sobre el escenario hablando del nuevo procesador Turing sin concretar información que siempre había sido básica en este tipo de presentaciones. Se limitó a hablar de Ray Tracing, el trazado de rayos, abreviado como RTX.

Todos los que seguimos la presentación nos quedamos con cara de circunstancias y la Red comenzó a llenarse de una corriente negativa hacia la nueva GPU que se acrecentó cuando empezaron a aparecer los primeros “benchmarks” que confirmaron las sospechas. El análisis más simplista es que NVIDIA nos quiere vender un hardware que no mejora el rendimiento a un precio tan alto que casi resulta absurdo. Cosas de la falta de competencia, decían unos. Una tecnología inútil a precio de oro, apuntillaban muchos otros.

Cada uno de nosotros llegaba a sus propias conclusiones, pero no ha sido hasta haber probado la tarjeta y, sobre todo, habernos “empollado” el extenso “White Paper” explicativo de NVIDIA, que no hemos sabido interpretar qué pretenden con su nuevo chip.

Tocando techo

Para entender el movimiento de NVIDIA podríamos comenzar con un simple ejercicio de memoria. Echad la vista atrás y recordad los juegos que más os han impactado por su calidad gráfica; aquellos que realmente os han dejado con la boca abierta al suponer un salto realmente revolucionario respecto a todo lo visto.

Habréis comprobado cómo todos los grandes saltos gráficos, esos títulos realmente revolucionarios, los Doom, Quake, Unreal, Half Life, Crysis, Bioshock… tienen ya unos añitos. Probad un segundo ejercicio de memoria. Traed a vuestra mente series aún activas como Battlefield, Assassin’s Creed, Call of Duty, Far Cry… y comparad el aspecto gráfico de su lanzamiento más reciente con el de hace 5, o incluso 10 años… Efectivamente, la mejora gráfica es muy pequeña. Nada que ver con la que había entre los títulos distantes entre sí 5 años allá cuando corrían los 90 o los 2000.

Sí, la culpa es de las consolas, principal fuente de ingresos en el mercado del videojuego que mantienen la vigencia de su hardware durante ciclos de 8 años, con las limitaciones que ello conlleva. El estancamiento del hardware durante esos ciclos y la escasa rentabilidad de hacer un buen “port” de consola a PC son una de las causas de que los usuarios de PC no cabalguemos hacia el fotorealismo a la misma velocidad que lo veníamos haciendo. Ese es un dogma que cualquier “PC Master Race” ha interiorizado pero que, asumámoslo, no es del todo cierto.

La razón real de que vivamos un auténtico estancamiento en la progresión gráfica hacia el citado fotorealismo se encuentra en que hace tiempo que rozamos los límites de las tecnologías y técnicas establecidas en esta industria desde el mismo inicio de las 3D.

Hemos evolucionado gráficamente a fuerza de aumentar la cantidad y velocidad de los procesadores y memorias. Más potencia equivalía a más polígonos, con texturas más detalladas y moviéndose más rápido. Esa es, hasta ahora, nuestra carrera hacia el realismo gráfico.

Hemos salpicado esta apuesta por la potencia bruta con pequeñas implementaciones muy concretas dirigidas a mejorar la representación de fluidos, tejidos, partículas o el pelo, pero lo que siempre hemos esperado de un nuevo procesador es una mayor velocidad de reloj, una mayor cantidad de procesadores y, a ser posible, en un menor espacio y con un menor consumo y generación de calor. Vamos, hemos reclamado al pie de la letra lo previsto por Gordon Moore hace casi sesenta años y plasmado en la Ley con su nombre que se ha mantenido vigente desde entonces.

Pero todo llega a su fin. La actual carrera por duplicar la potencia de los procesadores ha tocado techo. Sí, exactamente igual que la evolución gráfica de nuestros juegos. La propia Intel, fundada por el señor Moore y principal valedora de su Ley, reconoce que ésta se ha dejado de cumplir. Con los procesadores de 7 nanómetros a la vista, en Intel tiran la toalla asumiendo que el año que viene, o en 2020, la famosa Ley de Moore se dejará de cumplir definitivamente. La actual tecnología no da para más. Es hora de cambiar. Llega el momento de que llegue un paradigma que establezca las bases de la futura evolución. Ese paradigma podría basarse en tecnologías de las que llevamos oyendo veinte años, como el grafeno o los procesadores cuánticos, que no acaban nunca de llegar. Quizá llegue con un uso diferente de la tecnología actual, buscando la escalabilidad o cualquier otra opción de seguir aumentando prestaciones. Lo veremos pronto.

NVIDIA toma una decisión

Sobre este panorama NVIDIA con sus 2080 intenta dar ese paso; abandonar una línea de progresión que mostraba evidencias de agotamiento, para apostar por una vía alternativa. Los taiwaneses no es la primera vez que lo hacen. De hecho fueron ellos los que cambiaron para siempre los juegos de PC lanzando sus primeras Riva y estandarizando la aceleración 3D por hardware. Su aportación realmente paradigmática llegó con la concepción de la primera GPU, las omnipresentes GeForce, que establecieron el uso de un coprocesador exclusivamente dedicado al desempeño gráfico. Aquello lo cambió todo. Corría el año 1999 y en cuestión de meses, ya con las GeForce 2 MX, NVIDIA tomo el mando de la industria, anulando cualquier competencia a excepción de una encomiable ATi que hasta hoy es la única capaz de plantar cara.

Desde entonces, en diecinueve años y dieciséis generaciones de GeForce, la evolución ha sido sostenida, incorporando tecnologías muy interesantes como los Shader, el SLI, la computación GPGPU, los cálculos Physx y la computación en paralelo de la arquitectura CUDA. Para tomar perspectiva de esta evolución y del terco cumplimiento de la Ley de Moore basta decir que los primeros chips gráficos de NVIDIA contaban con 3 millones de transistores. Las primeras GPU GeForce ya tenían 23 millones, mientras que las recientes GeForce 1080ti cuentan con 12.000 millones de transistores.

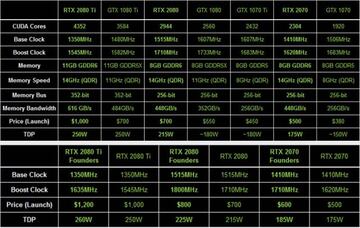

Y en este momento llega la serie 20. Las 2080 rompen ya la ley de Moore y se quedan en 13.600 millones de transistores; 18.600 en el caso de las 2080Ti. Si hablamos de la velocidad del procesador, la GeForce 1080 corre a 1607 MHz, mientras que su reemplazo, la GeForce 2080, lo hace a 1515 MHz.

Analizando las frías cifras NVIDIA habría sacado una nueva generación con un hardware igual o inferior a la generación anterior, a un precio muy superior y con mayor consumo eléctrico y temperaturas. ¿Qué ha pasado?

Hardware de futuro

En este punto es donde el artículo se adentra en el terreno de la fe, en el convencimiento en algo que ni hemos visto, ni tenemos pruebas de que exista. Lo único que tenemos son los diagramas y PDF de NVIDIA, los vídeos, y un buen número de promesas. Pasamos a interpretar, a transmitir algo que, quizá, NVIDIA no ha sabido explicar en sus presentaciones.

Partimos de que NVIDIA con su 2080 pretende dar un giro de timón, un cambio de época, una revolución tecnológica como la que propició hace 20 años con las primeras GeForce. El artículo hasta este punto pretendía presentar el escenario que obligaba a NVIDIA a buscar nuevas vías de desarrollo. La que ha encontrado, aquella que ha decidido tomar, es la de la especialización. Tan simple como eso. ¿Qué cambia en las 2080 respecto a las anteriores GeForce? Sencillamente que se pasa de tener un procesador multitarea a sumar otros procesadores paralelos que se ocuparían de determinadas tareas gráficas. Ya está.

Otra máxima que podría haber sido de gran ayuda a NVIDIA para presentar su producto diría que, si bien el chip principal tiene la misma potencia que en la generación anterior, ahora tiene una menor carga de trabajo porque lo va a compartir con otras unidades de proceso que no existían hasta ahora. Si la GPU no tiene que ocuparse de tareas como la iluminación o el antialias, puede destinar todo su potencial a otras tareas. En definitiva, la potencia es mayor y los rendimientos deberían ir de la mano a esa mayor capacidad de procesamiento.

¿El problema de todo esto? Que si bien NVIDIA podría haber acertado con la solución, no lo ha hecho con el tiempo y las formas.

Si desde el principio desestimamos la idea de analizar y medir el rendimiento de la “Founders Edition” que nos envió NVIDIA es porque todo aquello que la hace superior a la anterior generación no funciona. Aún. Esa es la razón de que en las comparativas que se han llegado a publicar las 2080 rinden igual o menos que las 1080 y eso, tanto para el fabricante como para los clientes, es un problema. Un problema que se irá corrigiendo a medida que llegue al mercado el software capaz de sacar partido al nuevo planteamiento de NVIDIA. A día de hoy ese software no existe más allá de alguna demo o benchmark sintético.

Será Microsoft la primera en solventar parte de esta incómoda situación incluyendo en la actualización de Windows 10 de este mismo mes los DirectX 12 con su API DXR, o DirectX Ray Tracing, que permitirá a todos los desarrolladores el aprovechamiento transversal del nuevo hardware de NVIDIA. Una vez estén listas las herramientas es cuestión de tiempo que los programadores las utilicen en sus nuevos títulos. Algo en lo que se ha insistido mucho es en la sencillez con la que cualquier programador puede implementar las nuevas tecnologías en su título, dada la perfecta interacción que existe entre el hardware de NVIDIA y el software Windows de Microsoft.

Será entonces, cuando el software demande de las nuevas características de la Serie 20 y veamos los resultados; cuando realmente podamos analizar lo que ha hecho NVIDIA, lo que ahora solo podemos suponer.

Trazado de rayos, Inteligencia Artificial y Antialias

Si os fijáis, hemos acabado prácticamente este reportaje sin hablar de Ray Tracing. Aquello que llenó completamente la presentación de NVIDIA en Alemania nos parece algo mucho más circunstancial que todo lo que lleva por detrás. NVIDIA ha cambiado la forma en la que concibe su hardware, montando procesadores paralelos destinados a asumir determinados procesos y descargar de trabajo a la GPU principal… y sí, el primero y más importante de esos procesos es el Trazado de Rayos.

Pero no nos equivoquemos. El Ray Tracing no es algo nuevo y está ahí desde que se empezaron a crear las primeras escenas 3D. A día de hoy se utiliza de forma intensiva en el cine, en cualquier película con un elemento generado por ordenador, tanto en las de imagen real (Marvel), como en las animadas (Pixar). Explicado de forma rápida y simple, el Ray Tracing calcula el color de cada texel analizando la luz que llega hasta él. En un escenario 3D simple esta luz sería la del foco o focos que se hayan programado. En un escenario con Ray Tracing se calcularía no solo el color generado por esos focos, además se tendría en cuenta los diferentes rebotes de esos rayos de luz en las distintas superficies, lo que alteraría su color. Un ejemplo muy fácil de imaginar es el de un desván con un tragaluz en la pared por el que se cuela un rayo de luz que ilumina el suelo. Sin Ray Tracing la zona iluminada sería aquella en la que impacta el rayo de luz. Con Ray Tracing se calcularía cómo esa luz, al rebotar en el suelo, ilumina el techo y cómo esa menor cantidad de luz que llega al techo vuelve a rebotar e ilumina otros elementos de la escena.

Lo que consigue Ray Tracing es iluminar una escena virtual del mismo modo en que sería iluminada en la realidad. Y lo que ha conseguido NIVIDA con su procesador de Ray Tracing es que un proceso que lleva horas de renderizado sea reproducido en tiempo real en un juego.

En este punto hemos de reconocer, ya de forma personal, que si NVIDIA ha conseguido que esto sea así, que realmente tengamos en lo que queda de década juegos iluminados con Ray Tracing en tiempo real, contarán con toda nuestra admiración y agradecimiento. Y es que con esta tecnología todo lo que venimos contando en este artículo cobra sentido. El salto en la calidad gráfica de los juegos será impresionante. El paso dado hacia el fotorealismo será casi definitivo.

Lamentablemente somos escépticos en esta cuestión. No en el hecho de que el Ray Tracing vaya a cambiar los videojuegos, sino en el cuándo lo va a hacer. Y nos basamos en la tremenda potencia y tiempo que requiere una escena para ser completamente iluminada mediante esta tecnología. Cada fotograma de una película de Pixar requiere horas de procesamiento y es literalmente imposible que con la tecnología de hoy eso se pueda generar en tiempo real. Así que nos inclinamos por la hipótesis de que esta tecnología se irá implementando poco a poco, limitándose a pequeños efectos en estas primeras generaciones, para ir ganando efectividad en las siguientes. Eso sí, el primer paso, la primera piedra, ya está puesta.

Y aunque el Ray Tracing parece que es lo único que aporta esta nueva Serie 20, por nuestra parte queremos destacar otra tecnología que se nos antoja mucho más interesante. No porque sus efectos vayan a ser tan impresionantes, sino porque está disponible desde ya. Hablamos de los denominados nucleos TENSOR y que introducen la Inteligencia Artificial y el “Deep Learning” en un hardware dedicado como son las GeForce. Estos núcleos pueden ser programados para distintas funciones que requieran el análisis y optimización automático, dicho llanamente, que el propio hardware aprenda por sí mismo a hacer mejor su trabajo.

La primera utilidad que conocemos de estos nuevos núcleos es el Deep Learning Super Sampling, DLSS. Este proceso permite suavizar toda la escena, dotándola de realismo, de una forma más efectiva y menos costosa que la mejor tecnología de antialising utilizada hasta ahora, el TSSAA.

Las pruebas que hemos hecho alternando esta tecnología y el antialias habitual muestran un aumento de rendimiento muy alto, pero no lo consideraremos hasta que podamos probarlo en juegos reales, no en demos.

En todo caso la incorporación de la Inteligencia Artificial a un hardware dedicado a mover juegos como es éste nos parece algo a celebrar y que suma crédito a la apuesta de NVIDIA. Eso sin entrar en cómo esta tecnología puede dar un buen empujón a la hoy estancada Realidad Virtual, una tecnología que sí es ilusionante como ninguna otra. Pero, como ya hemos dicho, aún nos falta su grado de eficiencia.

Y por último, obviando el resto de mejoras, inferiores en importancia a las citadas, queremos hablar de NVLink, el nuevo interfaz de conexión entre distintas GPU que sustituye a SLI. La nueva arquitectura con múltiples procesadores y reparto de tareas requería una conexión mucho más eficiente que SLI. Las nuevas velocidades, anchos de banda y latencias que permiten esta tecnología promete sacar todo el rendimiento a las combinaciones de varias tarjetas. Quizá ahora sí que lleguemos conseguir que dos tarjetas gráficas realmente rindan el doble que una. Otra cuestión que también hemos de comprobar.

En definitiva…

El nuevo hardware de NVIDIA promete. El problema es que por el momento solo hace eso: prometer unas mejoras que hoy día no ofrece. Por el contrario, al comprador sí que le exige un tremendo esfuerzo económico. La pequeña (por ahora) de la generación, la 2070, está hoy a la venta por unos 640€. Una 2080 asciende hasta los 850 €, mientras que las 2080Ti se van hasta los 1260€. Yo me compré mi primer coche por menos dinero. No creemos que hoy día gastar tal cantidad de dinero en un hardware que aún no ofrece todo su potencial sea recomendable. Tan solo en el caso de que tengamos un presupuesto muy alto y las alternativas que nos planteemos sean una 1080 Ti y una 2080, nos decantaríamos sin duda por la serie nueva. Si bien es ligeramente más cara, es de esperar que en cuanto se lancen los primeros títulos que aprovechen su tecnología, la diferencia de rendimiento se dispare.

Para los demás, los que no podemos disfrutar de un hardware de ese nivel, disfrutemos al menos de lo que está por llegar. Veamos cómo los nuevos juegos aprovechan el Ray Tracing, cómo la Inteligencia Artificial se cuela también en las tripas de los PC, cómo Microsoft aprovecha la posición privilegiada que le da Windows en su apoyo al Ray Tracing y, por supuesto, cómo lleva esta tecnología a sus X-Box. Ya estamos ansiosos por ver cómo AMD/ATi encajan este lanzamiento y presentan su alternativa. Y por encima de todo, veremos si esta apuesta de NVIDIA pasa a la historia como una revolución o como simple palabrería y marketing.

En definitiva, que nos esperan unos meses muy entretenidos; apasionantes si somos de los que seguimos de cerca el hardware gráfico. Llevamos lustros sin propuestas de una profundidad como la que ahora plantean NVIDIA y Microsoft. Sin ver, tampoco, aquellos grandes avances en la calidad gráfica que tanto echamos de menos. Y ya es hora. Llega el fin de una era y NVIDIA ya ha dado un paso hacia la siguiente. El tiempo dirá si su dirección es la correcta.