Animación facial y Uncanny Valley: ¿evasión o victoria?

La proyección de los sentimientos humanos a través del rostro es, sin duda, uno de los desafíos más complejos a los que se ha enfrentado el mundo de la representación visual. Te invitamos a un interesante viaje a través del mundo del arte, la ciencia, la medicina y, como no podía ser de otra manera, los videojuegos, abordando con detalle una compleja materia.

Viajemos en el tiempo. Hacia un futuro no muy lejano. Corre el año 2050, llegamos al piso tras una dura jornada de trabajo y, pese a que hemos estado alejados de nuestro querido gato durante todo el día, se encuentra en perfectas condiciones: nuestro compañero androide se ha encargado de cambiarle la arena, darle de comer y prestarle toda la atención que necesita para sentirse querido.

Aprovechamos para descalzarnos, descansar en nuestro sofá durante unos minutos y relajarnos jugando a algún videojuego o viendo nuestra serie predilecta. Pero mientras nos acercamos, él se encuentra en el silloncito de al lado mirando a la nada. Impasible. Mientras su procesador central le advierte de nuestra presencia, su cabeza —de acabado hiperrealista, ataviada con millones de cabellos, provista de una piel prácticamente indistinguible de una tez real y capaz de gestionar más de un millón de emociones— gira de manera violenta hacia nosotros mientras una sonrisa bastante perturbadora precede a unas amables palabras: bienvenido a casa, ¿qué tal ha ido el día en la oficina?

Resulta mucho más inquietante que si pensásemos en la misma escena, sustituyendo el Robot hiperrealista por uno mucho más parecido al que interpretaba nuestro querido Robin Williams en la primera mitad del film El Hombre Bicentenario (Cris Columbus, 1999), ¿verdad? Esto podría servirnos para explicar, de forma sencilla ligera, el fenómeno conocido como el Uncanny Valley o Valle Inquietante, teoría surgida en el campo de la robótica que asegura, a grandes rasgos, una extendida hipótesis: mientras más se parezca a nosotros un ser artificial más resaltarán sus características no humanas haciendo que sintamos rechazo, falta de empatía e incluso temor hacia esta forma sintética.

Creando vida en el sector interactivo

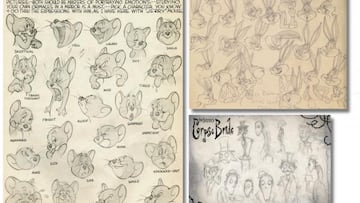

Como era de esperar, el mundo de los gráficos generados por ordenador se enfrentaba a un problema difícil de sortear durante sus inicios, pues a medida que el realismo a la hora de diseñar y animar personajes CGI se acercaba más y más a la realidad, el peligro del Valle Inquietante se hacía más feroz. En el mundo del cine, películas como Final Fantasy: La fuerza Interior (Hironobu Sakaguchi, 2001) o El Regreso de la Momia (Stephen Sommers, 2000) se vieron afectadas por esta problemática, mientras que obras como Jurassic Park (Steven Spielberg, 1993) o Los increíbles (Brad Bird, 2004) sorteaban el problema a través de dos vías diferentes: la primera por medio de la representación de seres vivos que nunca hemos visto en directo ni se asemejan a la estructura del ser humano, y la segunda ofreciendo una dirección artística cartoon cuyas exageradas animaciones y llamativas proporciones alejaban lo suficiente a sus personajes del realismo del ser humano para que el espectador empatizase con ellos.

Problemáticas similares hemos vivido a lo largo de la historia del cine. La expresividad de personajes cartoon como los que protagonizan títulos a la altura de Monkey Island (Ron Gilbert, 1990), Day of the Tentacle: Maniac Mansion 2 (Tim Schafer y Dave Grossman, 1993) o Earthworm Jim (David Perry, 1994) han servido de inspiración para producciones tridimensionales como Team Fortress 2 (John Cook y Robin Walker, 2007) o Ratchet & Clank (2002). No obstante, mientras que el realismo en videojuegos se mantenía en valores alejados todavía de la realidad —sintonizar con los personajes de títulos como Metal Gear Solid 3: Snake Eater (Hideo Kojima, 2004) o Silent Hill 3 (Kazuhide Nakazawa, 2003) se hacía sencillo—, la siguiente generación llegó para introducir herramientas de edición y animación nunca antes vistas, pero que traían consigo el temido Uncanney Valley.

Franquicias como Mass Effect o The Elder Scrolls fueron las más afectadas por esta particular casuística; la densidad poligonal dedicada a los rostros del comandante Shepard o de Miranda Lawson, así como la recreación de la piel o los ojos llegaban a cotas bastante realistas, lo que enfatizaba más aún los fallos en la animación facial y la interpretación de las metáforas expresivas. Por su parte, creativos como David Cage seguía explorando los límites de la recreación realista, con Heavy Rain (2010) primero y con Beyond: Two Souls (2013) después, en aras de establecer nuevos cánones en la lucha contra el temido Uncanny Valley. La victoria aún quedaba lejos, pese a que la demo de KARA presentada la GDC 2012 nos hizo soñar con nuevos límites en lo que a captura de movimientos faciales se refieren, mientras compañías como Image Metrics o Mova Contour System seguían perfeccionando sus herramientas dedicadas a la producción de cine y videojuegos. Durante su presentación de la GDC 2013, David Cage habló sobre la sorprendente demo tecnológica The Dark Sorcerer presentada en el E3 —esta vez trabajando sobre PS4—y aprovechó para ofrecernos un aperitivo sobre lo que podría llegar a conseguir en Quantic Dream en su próximo proyecto:

Todo ello nos lleva a la actualidad, y de nuevo las preguntas clave se hacen necesarias. ¿Se ha conseguido recrear de forma realista la biomecánica del cuerpo humano a nivel global, gracias a las herramientas de Fotogrametría y animación avanzada? ¿Hay sensación de vida en personajes virtuales tan avanzados como Nathan Drake (Uncharted 4), Harley Quinn (Injustice 2) o Aloy (Horizon Zero Dawn)? ¿La nueva producción de David Cage bajo el sello de Quantic Dream, que responde al nombre de Detroit: Become Human (evolución en formato videojuego de la demo KARA), se convertirá en un nuevo referente en cuanto a la representación de las emociones en tiempo real dentro del mundo del videojuego? Antes de responder a tamañas preguntas, nos gustaría echar la vista atrás para ver la importancia de la problemática, para conocer las principales referencias dentro del mundo del arte, la ciencia, la medicina y la producción audiovisual a lo largo de la historia.

La figura humana como adalid de la belleza

Muchos de vosotros posiblemente creáis que la problemática generada a raíz del Uncanny Valley se puso de relieve durante la creación de los primeros robots avanzados de apariencia humana y las hipótesis formuladas por científicos como Masahiro Mori durante la década de los 70. No obstante, a lo largo de la historia del arte siempre se ha tenido especial inquietud por el hecho de recrear el rostro humano de forma fidedigna.

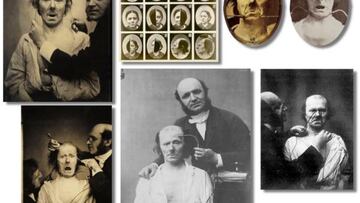

Gracias a los estudios científicos llevados a cabo por G.B Duchenne de Bologne a finales del siglo XVIII y principios del XIX, perpetuados por el Dr. Fritz Lange a hasta el S. XX, el conocimiento de los músculos faciales y de cómo actuaban conforme a los diferentes estados de ánimo del sujeto creció exponencialmente. Fritz, principal impulsor de la ortopedia moderna y científico especializado en crear vínculos entre varias disciplinas referentes al estudio del cuerpo humano, supo ver más allá de la comunidad científica con el objetivo de profundizar en la problemática del rostro humano.

Por su parte, Duchenne aplicaba pequeñas descargas eléctricas directamente sobre el sujeto, con el objetivo de estimular determinados músculos para estudiar el efecto que producían a nivel superficial.

Las fotografías que existen sobre dichos experimentos resultan, cuanto menos, turbadoras. Por definir un símil desde el mundo del videojuego, los experimentos de Duchenne generaban el desasosiego propio del Valle Inquietante: como se estimulaban grupos de músculos por separado, el resultado era parecido al que podemos observar en animaciones faciales que no utilizan sistema de captura de movimientos. Los rostros de Mass Effect 2, muchas veces, solo tenían en cuenta zonas específicas de la anatomía facial, haciendo que otros muchos no intervinieran en metáforas expresivas como la alegría, el llanto o la rabia.

Y esto es algo que, sorprendentemente, también ha ocurrido en producciones más modernas, entre ellas la polémica última entrega de esta misma saga. Las animaciones faciales de Mass Effect: Andromeda (Mac Walters, 2017) caen hasta lo más profundo del Uncanny Valley por ese motivo. Frente a nosotros se presentan personajes de gran realismo, tanto en la iluminación como en la representación de superficies complejas (como la piel o el cabello). Este hecho hace que cualquier fallo, error de programación o animación poco trabajada, multiplique su notoriedad, haciendo de las escenas cinemáticas de Mass Effect: Andromeda una experiencia que genera un rechazo automático en el jugador, mucho más acusado que en producciones como Dragon Age: Inquisition (Mike Laindlaw, 2014) o The Witcher 3 (Konrad Tomaszkiewicz, 2015). También contribuye el hecho de que en este tipo de producciones no se suela utilizar una base con captura de movimientos.

En el mundo artístico, figuras tan diversas como Leonardo da Vinci, Carabaggio, Pieter Paul Rubens, Pablo Picasso, Salvador Dalí, el Greco, Frida Kalho o Margaret Keane formaron su propia imaginería alrededor de la figura humana desde diferentes perspectivas: la representación del rostro y el cuerpo cobraba especial importancia en cada una de ellas. Pintura, escultura, grabado y dibujo, darían paso a otras artes como el Daguerrotipo y la Fotografía, casi siempre bajo el prisma de captar el instante dentro de imágenes fundamentalmente estáticas. Interpretar el momento. Un gran desafío que, no obstante, quedaba alejado de la problemática subyacente dentro de la imagen dinámica basada en la sucesión de fotogramas: el cine y la animación hacían acto de presencia.

Fue con la aparición del arte en movimiento cuando las expresiones del cuerpo humano cobraron una nueva dimensión. Asimismo, técnicas como la rotoscopia o la pixilación se revindicaban como los principales referentes de la futura captura de movimientos, mientras producciones como Blancanieves y los 7 enanitos (Walt Disney, 1937) o series como Out of the Inkwell (Mark Fleishcher, 1938) se aprovechaban de los últimos avances en este sentido para dar vida a sus personajes.

El mundo del videojuego no tardaría en inspirarse en dichas técnicas, con creativos a la altura de Jordan Mechner o Ed Boon ofreciéndonos producciones de la magnitud que demostraron The Last Express (1997) o Prince of Persia (1989) en el primer caso, o Mortal Kombat (1992) en el segundo. Mechner era un absoluto maniático del realismo en la representación del cuerpo humano a través de la rotoscopia, mientras que Boon investigó en el campo de la Pixilación como principal referencia para los personajes digitalizados de los primeros videojuegos de su saga de lucha.

Y, de nuevo, la llegada de otra revolución dentro del sector interactivo: la estandarización de los gráficos poligonales. Y de igual forma, el desafío de crear vida a partir de un puñado de polígonos, hecho que se puso de relieve en la tosca representación del cuerpo humano en tiempo real dentro de producciones como Virtua Fighter o Soul Edge. No sería hasta el año 1998 cuando empezarían a aparecer los primeros signos de progreso en cuanto a representación facial se refiere. Y vino con videojuegos a la altura de Half Life (Marc Laidlaw), título donde veríamos por primera vez la implementación de sistemas de gesticulado y sincronización labial en tiempo real.

Años de investigación permitieron marcar hitos como el conseguido con Metal Gear Solid 3: Snake Eater o Silent Hill 3, techos tecnológicos de su época en cuanto a animación facial y representación de las metáforas expresivas dentro del mundo del videojuego. Por suerte o por desgracia, la limitada tecnología imposibilitaba lograr un realismo mayor en cuanto a iluminación, texturizado y modelado de alta densidad poligonal como para acercarnos a la sensación de realidad, lo que también alejaba el problema del Uncanny Valley del mundo del videojuego. Hasta que Xbox 360 y PS3 dieron el pistoletazo de salida a la nueva generación de gráficos generados por ordenador en tiempo real.

Una nueva frontera en el mundo de la representación realista

Como había ocurrido en el mundo del cine y la animación por ordenador, siempre y cuando la dirección artística de la obra se asentara en un planteamiento con cierto grado de caricaturización —como en las películas de Pixar o Dreamworks—, o los protagonistas se caracterizaran por un diseño original —en la línea de los Krogan de Mass Effect—, el problema del Uncanny Valley no resultaría demasiado amenazante.

Eso sí, la persecución del realismo como uno de los pilares del desarrollo del mundo del videojuego siempre ha sido de gran importancia, con creativos como David Cage o Sam Lake intentando imprimir credibilidad visual a cada una de sus obras. Tras el destacable Fahrenheit (2005), Quantic Dream puso toda la carne en el asador con Heavy Rain (2010). Actores reales, un sistema de captura de movimientos y animación facial de vanguardia que, desafortunadamente, se topó de lleno con el implacable Uncanny Valley. Cualquier incoherencia en el movimiento de los ojos en los personajes generados en tiempo real, la inconsistencia en la animación de las comisuras labiales o la ausencia de un movimiento convincente de la lengua en el interior de la boca generaba, muchas veces sin saber por qué, una sensación de rechazo directa en el espectador.

La problemática se acentuaba en personajes como el comandante Shepard dentro del videojuego Mass Effect (Casey Hudson, 2007). Mientras que las especies alienígenas mostraban un imponente y creíble aspecto (más que nada porque no relacionamos su ejecución con ningún elemento que podamos rescatar directamente de la realidad más allá de su inspiración reptiliana), los personajes humanos arrojaban una sensación incómoda e inquietante. Unido a que el sistema de animación no se apoyaba en ningún método de captura de movimientos, y el realismo en la representación de otros elementos de los personajes (como la biomecánica del cuerpo humano, la iluminación o la recreación detallada de los poros de la piel mediante Bump Mapping), los Bugs que podíamos encontrarnos durante las conversaciones y los extraños movimientos que podían llegar a producirse durante una escena de vídeo acrecentaban el problema.

Tal vez por ello Naughty Dog, estudio plagado de expertos en animación, recreación de movimiento cartoon y diseño de mundos imaginarios de carácter fantástico, intentó una aproximación —moderada— hacia el realismo en la primera iteración de la serie Uncharted (Amy Hennig, 2007): antes de enfrentarse al temido Uncanny Valley, no está de más allanar el camino. Mientras tanto, equipos de desarrollo como Team Bondi optaban por sistemas alternativos en cuanto a la representación realista del gesto facial: el videojuego L.A Noire (Brendan McNamara, 2011), distribuido bajo el sello Rockstar y recuperado recientemente en una versión remasterizada para PS4, Xbox One, PC y Nintendo Switch, llamó poderosamente la atención de los desarrolladores por sus novedosos métodos de representación facial, a partir de la técnica Motion Scan.

Este método, basado en la filmación de actores reales por medio de un sistema multicámara, capturó todos los matices de la expresión facial en numerosos vídeos desde múltiples puntos de vista. Para llevarlos al entorno interactivo, se utilizaron procesos complejos para la sincronización de la captura de movimientos y la malla de cada personaje, a la vez que se utilizaban texturas dinámicas que contenían las expresiones faciales grabadas en vídeo.

Es decir, horas y horas de metraje incrustadas en los modelos tridimensionales con el objetivo de capturar todos los matices de su expresividad facial. El resultado es, incluso hoy en día, realmente sorprendente, pese a no poder contar con modelos de alta densidad poligonal y el hecho de que las texturas dinámicas no tuviesen la calidad de las tradicionales, hacían que el Uncanny Valley hiciese acto de presencia, sobre todo, cuando la cámara se situaba muy cerca del jugador y en posiciones algo forzadas.

Muchos nos preguntábamos por qué no se evolucionó esta técnica en producciones posteriores. La respuesta es sencilla: para conseguir texturas dinámicas 4k trabajando a 30 o 60 fotogramas por segundo, teniendo en cuenta la cantidad de personajes que hay en este tipo de videojuegos, se ocuparía una cantidad ingente de espacio de almacenamiento. Terabytes y terabytes de información que serían tremendamente costosos de gestionar a nivel de espacio, con lo que ello conllevaría también en el plano del rendimiento técnico.

Presente y futuro de la representación tridimensional realista

No obstante, lo que antaño parecía una barrera prácticamente imposible de sortear, se ha convertido en un objetivo mucho más realista dentro del mundo de la producción cinematográfica. Y lo que resulta mucho más sorprendente: se están logrando resultados increíbles en el campo de la generación de gráficos en tiempo real gracias a los avances instaurados en los últimos sistemas de captura de movimientos. Más fiables, más cómodos para los actores, más precisos y, lo que resulta más importante, más fáciles de trasladar al motor del juego sin que, por el camino, se pierda una ingente cantidad de datos.

También es de recibo ensalzar la labor del animador: sin los ajustes pertinentes y el talento de esta importante figura dentro del medio, sería imposible conseguir los asombrosos resultados de equipos como Naughty Dog, Supermassive Games, Rockstar Games, NetherRealm Studios o Sony Santa Mónica.

Figuras tan importantes del celuloide como Andy Serkis y su equipo se han dedicado en cuerpo y alma al desarrollo e implementación de estas tecnologías, tal y como demuestra las mejoras evidentes vistas al analizar personajes como Gollum o King Kong, junto con otros más actuales a la altura de César o Neytiri. Junto a ello, directores como Robert Zemeckis o David Fincher siempre han demostrado una pasión inusitada por la representación realista en el mundo de los gráficos por ordenador. Los resultados obtenidos por este último en El curioso Caso de Benjamin Button (gracias a los sistemas de captura de movimientos patentados por Image Metrics) suponen un hito en el mundo del cine en particular, y en el de la generación de gráficos tridimensionales a nivel general. Y, lo más importante, siempre con el foco puesto también en el sector interactivo:

Parece mentira que muchas de esas técnicas se estén utilizando en la actualidad en el mundo del videojuego —a menor escala y por medio de numerosos trucos, todo hay que decirlo—, con unos resultados tan espectaculares como inverosímiles. Pongámonos en situación; los fotogramas de una película de animación como Vaiana (Ron Clements, 2016) tardan horas en renderizarse, mientras que el espacio escénico interactivo mostrado en títulos como Horizon Zero Dawn (Mathijs de Jonge, 2017) se están gestionando en tiempo real a 30 fotogramas por segundo.

En cuanto a la problemática que nos ocupa, figuras de la animación como Frank Tzeng o artistas conceptuales a la altura de Ashley Swidowski han trabajado conjuntamente en la lucha contra el temido Uncanny Valley. El objetivo: dotar de vida a personajes tridimensionales gestionados en tiempo real, por medio de las nuevas herramientas de edición y utilizando recursos inspirados en el mundo de la historia del arte y del estudio de la anatomía humana.

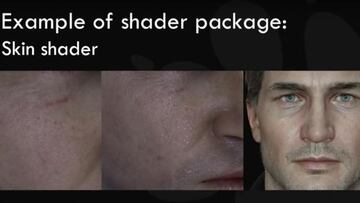

De esta forma, los ojos de los protagonistas de Uncharted 4 (Neil Druckmann, 2016) transmiten sentimientos, sus pequeños matices faciales nos asombran durante las escenas cinemáticas, y la recreación pormenorizada de su fisonomía logra que los veamos con total naturalidad: rápidamente nos olvidamos que estamos ante un amasijo de polígonos, texturas y shaders. Incluir factores individuales en cada personaje, representar imperfecciones propias de la piel y añadir el concepto de asimetría a la ecuación son algunas de las características más destacables.

Durante el Panel de Naughty Dog en la PlayStation Xperience 2014, Frank y Ashley nos mostraban la evolución de Nathan Drake a través del progreso del motor interno de la compañía. Resulta sorprendente cómo el sistema de huesos y músculos faciales de Nathan responden como un todo —al contrario que el ejemplo puesto sobre los experimentos de Duchenne—, interviniendo grupos enteros durante la representación de las distintas expresiones faciales. Destacan los movimientos laterales de la mandíbula, la acción del buccinador mientras se hinchan los mofletes del personaje, o cómo se combinan texturas dinámicas con mapas de normales para mostrar los pliegues de las arrugas en la frente, ojos y comisuras labiales.

No obstante, el factor anatómico necesita de muchos otros complementos para funcionar con coherencia. Uno de los más importantes lo encontramos en la iluminación, elemento en el que han trabajado durante años estudios a la altura de Quantic Dream o Remedy. El interesantísimo Paper publicado en marzo por Guillaume Caurant y Thibault Lambert con motivo de la GDC 2018 desvela elementos realmente interesantes que intervienen a lo largo del desarrollo de Heavy Rain, Beyond: Dos Almas y Detroit: Become Human.

La culminación de más de una década de trabajo la encontramos en el próximo videojuego de David Cage, que sale a la venta esta misma semana, y dónde las herramientas tanto de animación facial como de iluminación podrían suponer un nuevo referente dentro del sector. Además, el hecho de que los principales protagonistas sean androides hace que, en este caso concreto, cualquier signo de Uncanny Valley pueda ser justificable. Aunque también hay que evaluar el grado de éxito alcanzado en la recreación de los personajes humanos.

Iluminación volumétrica, Ambient Oclussion, superficies con diferentes capas de especularidad que absorben y repelen la luz de forma coherente, así como un sistema de sombreado complejo cuyo objetivo principal es simular la radiosidad sin que el rendimiento del videojuego que nos ocupa se vea comprometido. Hemos tenido la ocasión de probar el título en cuestión y podemos afirmar, sin temor a equivocarnos, que el equipo dirigido por Cage ha logrado un acabado visual realmente impactante, a pesar de que en cuestión de animación facial, en nuestra humilde opinión, queda margen de mejora al comparar el trabajo del estudio francés con el de compañías a la altura de Naughty Dog.

Del mismo modo que la animación facial, la mejora en la gestión del movimiento corporal de personajes virtuales adopta también un papel trascendental. Sistemas de huesos más complejos —que no sólo intentan reproducir la biomecánica del cuerpo humano, sino que añaden capacidad motriz a elementos que intervienen únicamente en aspectos secundarios de la animación— se adaptan como un guante a mallas con una densidad poligonal drásticamente superior a las utilizadas hace años. Estos aspectos, unidos al hecho de que los sistemas de animación tanto tradicional como asistidos por captura de movimientos son más sencillos de utilizar, ofrecen muchas más posibilidades a los artistas, y resultan mucho menos invasivos para el actor profesional, dan como resultado un gran momento para el mundo de la recreación del cuerpo humano por ordenador.

A los ejemplos que hemos puesto para ilustrar el presente artículo se unen logros impresionantes por parte de estudios realmente diversos. No es muy habitual que un videojuego de lucha sea objeto de estudio en cuanto a animación facial se refiere: el gran trabajo realizado por NeverRealm Studios en Injustice 2 (Ed boon, 2017) ha permitido que personajes como Harley Quinn se haya catapultado al estrellato más absoluto en este sentido. La animación facial y la interpretación exagerada de sus expresiones faciales dotan al personaje de un carácter muy acorde con su principal inspiración: la actriz que dio vida a este carismático personaje creado por DC en Escuadrón Suicida, la asombrosa Margot Robbie.

Existen muchos más ejemplos que nos dejamos en el tintero, como el de estudios a la altura de Supermassive Games en el sorprendente Until Dawn (Will Byles, 2015), el de Remedy por medio de la interpretación virtualizada del artistas como Shawn Ashmore o Courtney Hope en Quantum Break (Sam Lake, 2016), o el de Ninja Theory gracias al asombroso trabajo de Melina Juergens cómo la protagonista de Hellblade: Senua’s Sacrifice (Tameem Antoniades, 2017). Sin duda alguna, esto es tan solo un ejemplo del futuro que nos depara el mundo de la representación virtual del cuerpo humano, esperemos que dentro de unos años los logros realizados en el mundo de la robótica sean suficientes como para que nuestro compañero de piso virtual no de la impresión de querer intentar asesinarnos mientras dormimos durante una cálida noche de verano.

Referencias

Easley, T., & Smith, M. (1986). The Male and Female figure in motion. Nueva York: Watson-Guptill.

Plasencia Climent, C., & Rodríguez García, S. (1993). El rostro humano. Valencia: Universidad Politécnica, Departamento de Dibujo, Facultad de Bellas Artes de San Carlos.

Guillaume Caurant / Thibault Lambert (2018). The Lighting technology of Detroit: Become Human. Paper. Game Developer Conference 2018.

GDC Vault / Gdcvault.com (2018) [sitio web en línea] Disponible en https://www.gdcvault.com [Consulta: 20 de mayo de 2018].