Aceleración 3D en la actualidad

Repasa con nosotros la actualidad de la aceleración 3D para PC: una nueva guerra se prepara en el campo de batalla que ofrecen las DirectX9.

La guerra que se avecina

Se acerca el lanzamiento de las DirectX9, las librerías de Microsoft para los desarrolladores de juegos. Como en ocasiones anteriores, NVIDIA y ATI están preparados para aprovechar dichas librerías, sin embargo, esta vez hay otros...

Si hay un mercado que evoluciona rápido en esto del hardware de PC es el de los chips gráficos. Pero más que estar interesados en las velocidades de los chips y memorias, como en el mundo de procesadores y RAM, los jugadores queremos saber qué van a ofrecer estos nuevos chips.

Como otras veces, antes del lanzamiento de una nueva versión de DirectX, los diversos fabricantes de chips gráficos empiezan a anunciar sus nuevos productos, utilizando la compatibilidad con esta librería como argumento de ventas. Ya pasó con la versión 8 y con la 8.1 y... ¿Cómo? ¿Qué no os acordáis? Bueeeno, hagamos un poco de memoria...

/es/node/ArrayA mediados de Febrero de 2001 aparecía un nuevo chip de NVIDIA llamado GeForce 3, incluyendo como novedades más jugosas una cosa llamada vertex y pixel shaders, que permitían aplicar pequeños programas a los vértices y las texturas de cada escena tridimensional (muy útil para el agua por ejemplo, como veis en la imagen de Sea Dogs 2 de aquí al lado). Como estas características eran precisamente las novedades de DirectX8, el gigante californiano aprovechó la coyuntura para cantar las maravillas de esta API y mostrar en unas cuantas demos el potencial de su nueva tarjeta. Unos meses más tarde ATI hacía lo propio con su Radeon 8500, aprovechando el lanzamiento de las DirectX8.1, que permitían emplear pixel y vertex shaders de la versión 1.4, lo que supuestamente aceleraba ciertos cálculos al permitir mayor número de instrucciones. Y no nos olvidemos de MadOnion, que cada vez que aparece una nueva versión de estas librerías, ahí tenemos un 3Dmark que aprovecha sus capacidades para dejarnos con la boca abierta, no sólo por lo que vemos en pantalla, sino también porque empezamos a pensar que nuestra tarjeta gráfica se está quedando vieja.

/es/node/ArrayPero bueno, todo eso ocurrió con las versiones 8 y 8.1 de DX, con sólo ATI y NVIDIA peleando por la corona de la velocidad. Desde entonces, lo único que han hecho los dos ha sido mejorar la velocidad de sus chips y optimizar sus drivers, aunque NVIDIA aprovechó para colarnos otro 'nuevo' producto DX8: el GF4 Ti, que incluía una unidad extra para el tratamiento de vertex shaders, a imitación del chip gráfico de Xbox.

Como decía, hasta ahora las DX8 y 8.1 era lo que todos los juegos nos pedían al instalarlos, y sin embargo, son realmente pocos los que aprovechan alguna de las características de chips y librerías. Fijaos que digo JUEGOS y no demos tecnológicas o benchmarks y tal, porque no olvidemos que para aprovechar al máximo una tarjeta gráfica y divertirnos con ella necesitamos juegos que la exploten. Entre estos juegos, podemos citar Comanche 4, Morrowind, MotoGP, Dronez o Aquanox, aunque al tener que ser completamente compatibles con las tarjetas DX7 no pueden usar los nuevos efectos más que en algunos puntos muy concretos (agua o sombras, por ejemplo).

| Los realistas reflejos son fruto de las DX9 |

En fin, que como cada vez que sale una novedad en hard gráfico, todos los fabricantes nos intentan convencer de que se va a volver imprescindible. Ya pasó con el Transform & Lightning: que si íbamos a poder ver más polígonos en pantalla, que si el procesador podría disponer de más recursos al liberarlo de las tareas de iluminación y transformación, etc, etc. El resultado es que hasta ahora, sólo hay un juego que EXIJA T&L: Spiderman, the Movie y parece sólo una cuestión de drivers, puesto que con un programita llamado 3dAnalyze, las Kyro/Kyro II pueden mostrar estos espectaculares gráficos sin problemas.

Pero vayamos al grano: DirectX9 saldrá dentro de poco y, ¿qué nos ofrece? Pues veámoslo:

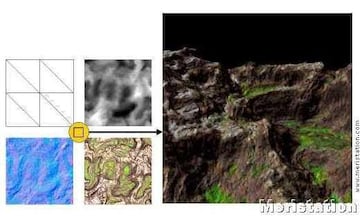

- Displacement Mapping. Una técnica que permite obtener modelos tridimensionales a partir de superficies planas y mapas de desplazamiento. Es similar al bump mapping, pero es mucho más potente porque se obtienen auténticos polígonos 3D, no sólo una modificación de la superficie. Eso quiere decir que el contorno del objeto también se verá afectado por el relieve y que las sombras de estas rugosidades serán más realistas. Este efecto puede servir para crear un paisaje rocoso a partir de un plano.

| Este es el procedimiento de Displacement Mapping |

- Precisión de color de 10 bits por canal. Hasta ahora, lo normal era que las tarjetas gráficas pudieran renderizar a 32 bits: 8 bits para el rojo, verde y azul y otros 8 para el canal alfa de transparencias. Con 10 bits para cada uno de estos componentes se obtienen degradados más suaves y transparencias más reales.

| Imagen en 40 bits de color (aunque no podamos verlo) |

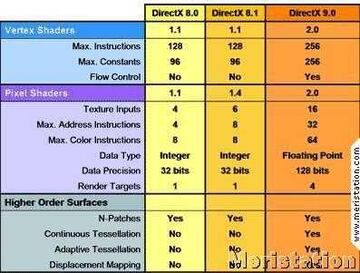

- Vertex y Pixel Shaders 2.0. Con la nueva versión de DX9, los PS y VS son totalmente programables y trabajan en coma flotante, con lo que la precisión de los cálculos mejora notablemente. Además, ahora se dispone de control de flujo (bucles, condiciones, etc) tanto estático como dinámico.

| Comparación entre las diferentes versiones de DX |

Y, ¿qué tarjetas van a poder usar vía hardware estas funcionalidades? Pues esa es la batalla que se está preparando. Presentemos a los contendientes...

3Dlabs VPU-10

El día de su presentación ya mencionamos sus principales características, pero hagamos un repaso. Dispone de vertex y píxel shaders totalmente programables, haciendo mucho más fácil el desarrollo para los diseñadores de efectos. Además, soporta multitarea gráfica, algo que en un futuro y con la aparición de Longhorn, el próximo sistema operativo de Microsoft, se volverá imprescindible.

Por otra parte, las tarjetas con este chip llevan memoria de 256 bits y disponen de memoria virtual, para que los programadores no tengan que preocuparse de direcciones de memoria. Además, sólo se recogen de memoria las texturas que se estén mostrando en ese momento, disminuyendo el impacto en el ancho de banda.

El chip en cuestión está fabricado en 0.15 micras por TSMC, lleva 76 millones de transistores y está en formato HSBGA de 860 bolas. Lleva cuatro motores de rendering, pudiendo aplicar dos texturas en cada ciclo de reloj.

En cuanto a su futuro, está claro que no es un chip para jugadores, pero puede encontrar un hueco en el mercado de los profesionales de las 3D, debido a su soporte de drivers para programas de este tipo, como 3D Studio. Creative debería de lanzar algún modelo más económico para jugadores, pero todavía no está confirmado.

| Displacement mapping aplicado a un terreno |

Matrox Parhelia

| Con tres monitores, podemos disfrutar de una experiencia de juego más inmersiva |

El revuelo inicial que causó este chip ha dado paso paulatinamente a un sentimiento de decepción generalizada por su bajo rendimiento. Efectivamente, pese a su memoria de 256 bits y su chip de 512, el Parhelia no es capaz de competir ni siquiera con una GeForce 4 Ti4600. ¿Por qué? Parece que es por falta de potencia bruta, pero Matrox no pretendía batir a nadie, sino que se ha tomado esta tarjeta como un experimento para futuros chips. Este nuevo chip lleva cuatro vertex shaders de 128 bits cada uno, permitiendo operaciones en coma flotante y que además son totalmente programables. Por ello, cumplen con los requisitos de DX9, pero no así los píxel shaders, que son como los de las GF3 y 4, compatibles DX8.1.

| Los chips compatibles DX9 (como el Parhelia) suelen llevar memoria de 256 bits |

Por otra parte, el chip no dispone de ningún mecanismo para la eliminación de superficies ocultas, por lo que debe confiar por entero al ancho de banda de que dispone, que es de algo más de 20 GB/s. Esta cifra puede parecer impresionante hoy en día, pero en un futuro no muy lejano puede quedarse corta.

| Un ejemplo de Displacement Mapping sobre un personaje |

Otra de sus características destacables es el soporte de color de 40 bits (10 por componente) y el Triple Head, que permite usar tres monitores simultáneamente tanto para trabajar como para algunos juegos que soportan este modo Surround Gaming.

Tampoco hay que olvidar el curioso método de Antialias que implementa: hasta 16X con una ligerísima pérdida de rendimiento, debido a que sólo se aplica a los bordes de los objetos, eliminando así el efecto de emborronamiento de texturas que todos hemos apreciado en nuestras tarjetas gráficas.

El chip está fabricado en 0.15 micras por TSMC, lleva 80 millones de transistores y cuatro motores de rendering, con cuatro texturas por ciclo de reloj. La velocidad del core es de 350 MHz y la de la memoria, de 700 MHz, pudiendo llevar hasta 256 MB de RAM.

ATI Radeon 9700

| Este oso está renderizado utilizando DX9 |

El último chip de ATI prácticamente acaba de llegar y ya está levantando pasiones. En las versiones más altas, el core va a 325 MHz y le acompaña memoria de hasta 256 MB dr 256 bits y 600 MHz. Está fabricado en 0.15 micras y lleva unos 107 millones de transistores. Se pretende pasar a 0.13 micras para poder elevar la frecuencia del core hasta 400 MHz, aunque esto no pasará antes de finales de año.

En cuanto a características, el R300 lleva 8 motores de rendering con una unidad de texturas cada uno (aunque puede renderizar 16 texturas de una pasada, requisito indispensable para DX9) y soporta Vertex y Píxel Shaders 2.0 y Displacement Mapping. Además, permite el rendering en 40 bits de color e implementa una serie de tecnologías para la optimización de los 19.2 GB/s de ancho de banda de que dispone (HyperZ III) o para la reproducción de vídeo aprovechando los shaders (Videoshader). Gracias a que el Antialias que hace usa el método de multisampling (mediante accesos al buffer z para calcular qué color debe mostrar ese píxel entre el borde del personaje y el fondo), apenas hay pérdida de rendimiento incluso a 4X. Tampoco el filtrado anisótropo parece afectar mucho a la tasa de frames, por lo que en configuraciones con AA y este filtrado, el R300 puede triplicar el rendimiento de una GeForce 4 Ti4600.

| Cuantos más bits de color, más realista la iluminación |

| La arquitectura del R300 |

NVIDIA NV30

Aunque parece que la compañía americana ha tenido ciertos problemas para producir su chip, el lanzamiento del NV30 sigue estando fijado para este invierno. El chip estará fabricado en 0.13 micras e irá a una velocidad de 450 MHz, con hasta 256 MB de DDR-SDRAM (incluso puede que DDR-II) hasta 900 MHz y con bus de 256 bits. El núcleo lleva interconexiones en cobre y contará con 73 millones de transistores. ¿Por qué tan pocos? Pues porque además del chip principal, los rumores apuntan a uno secundario que realizaría las funciones de T&L, recibiendo el nombre en este caso de TT&L (True Transform and Lightning) y que correría también a 450 MHz.

El NV30 será capaz de renderizar en 64 y 128 bits de color y el FSAA a 4X no provocará ninguna pérdida de rendimiento. Será totalmente compatible DX9 y OpenGL 2 y llevará 8 motores de rendering, con dos unidades de texturas por motor.

El chip incorporará la tecnología Lightspeed Memory Architecture III y llevará dos unidades de pixel shaders y cuatro de vertex shaders, exactamente el doble que las GF4 Ti. Para mejorar aún más el rendimiento de la memoria, el chip llevará un subsistema de caché cuádruple e implementará z-buffers duales para una compresión mejor y con menor pérdida de calidad.

Según los rumores, el NV30 será el primer chip de NVIDIA que incorpore parte de la tecnología adquirida a 3dfx, como el NvBlur. Se trata de algunas de las funciones que hicieron famoso el T-buffer de la Voodoo 5 y que permiten aplicar Motion Blur a los objetos en movimiento.

El chip también será capaz de reproducir MPEG2 íntegramente por hardware, igual que el bumpmapping. Además, llevará un modo de filtrado anisótropo '12nvx' que promete una mejora de calidad del 80% comparado con los métodos estándar.

Otros rumores que corren por la red como que el chip llevará 16 Mb eDRAM (embedded) con bus a 1024 bits y con ancho de banda de 70.4 GB/s o que sería necesario un nuevo sistema de refrigeración dado el calor generado por la GPU, han sido desmentidos. También se comentó que el chip podría correr en configuraciones multiprocesador, pero el coste de una tarjeta con dos de estos chips hace totalmente impensable su diseño. Además, ¿para qué tanta velocidad?

En fin, que sobre el papel, el nuevo chip de NVIDIA se muestra netamente superior al R300 y para demostrarlo, la compañía californiana ha hecho públicos varios documentos en su web que comparan ambos chips. De estos documentos hemos extraido las siguientes capturas, para que podáis comparar los dos chips más punteros.

|

| ||||

|

|

Trident Blade XP4

El Blade XP4 es una apuesta muy arriesgada por parte de Trident. Se trata de toda una gama de chips compatibles por completo con DX8.1 y parcialmente con DX9 (parece que finalmente sólo se implementará el Displacement Mapping) a un coste casi ridículo: 100 € el modelo de mayor rendimiento. Pero veamos antes que nada la familia al completo.

El modelo de gama más económica se llama T1 y lleva un core a 250 MHz, 64 MB de DDR-SDRAM de 64 bits a 500 MHz (ancho de banda de 4 GB/s) y costará menos de 69$.

El modelo de gama más económica se llama T1 y lleva un core a 250 MHz, 64 MB de DDR-SDRAM de 64 bits a 500 MHz (ancho de banda de 4 GB/s) y costará menos de 69$.

El modelo intermedio, el T2, lleva un core a 250 MHz, 64 MB de DDR-SDRAM de 128 bits a 500 MHz (ancho de banda de 8 GB/s) y costará unos 79$.

Por último, el T3 llevará un core a 300 MHz y 128 MB de 128 bits a 700 MHz (11.2 GB/s) y su precio será inferior a los 100 $.

Trident ha hecho hincapié en que incluso el chip más rápido, el T3, apenas disipa calor: tan sólo 4 W gracias a que está fabricado en 0.13 micras. Esto es muy importante para ordenadores con poca capacidad de refrigeración, como los portátiles o los mini PCs.

Ya hemos mencionado que todos estos chips serán totalmente compatibles con DX8.1, implementando pixel y vertex shaders (motor BrightPixel, con dos unidades de VS). También soportan descompresión por hardware de DirectX Video Acceleration (incluyendo IDCT y Compensación de Movimiento) y podrán mostrar la imagen simultáneamente en televisores, monitores y TFT. El chip soporta AGP 4X, lleva cuatro motores de rendering y dos unidades de textura por motor. Además, implementa tecnologías de ahorro del ancho de banda como SmartTile (para dividir la escena en celdas y ver qué objetos habrá que mostrar antes de realizar cálculos innecesarios), oclusion culling y demás.

| A la izquierda, bump mapping. A la derecha, displacement mapping. La diferencia es obvia |

Muy bonito todo, pero, ¿y el rendimiento? Pues Trident asegura que con los benchmarks que ha usado, el T3 alcanza el 80% del rendimiento de una GF4 Ti4600. Esto es, el T3 tendría un rendimiento muy similar al de una Ti4200, lo que no deja de ser sorprendente si tenemos en cuenta que vale menos de la mitad. De todas formas, los primeros benchmarks realizados con una muestra preliminar del T2 dan un resultado bastante más bajo que ese 80%. Pero tengamos en cuenta que es una muestra preliminar, con drivers no definitivos...

¿Por qué tan bajo precio? Pues porque se ha usado el menor número de transistores posible. Trident asegura que en vez de utilizar el mismo número para cada motor de renderizado, simplementa reutiliza funciones de ciertos transistores que se han usado para el primer motor. Si para el primero se usan 15 millones de transistores, para el segundo bastan 7.5 y así sucesivamente. Por eso bastan 30 millones de transistores (los que tenía una Radeon o una GF2) para crear un chip compatible DX8.1/DX9. Esto implica una reducción enorme de costes de fabricación.

El presente

Ya hemos visto los chips que soportan total o parcialmente características de las nuevas DirectX, pero recordemos que no habrá juegos que las usen hasta dentro de algún tiempo. Hagamos un breve repaso por los chips que están compitiendo AHORA MISMO por hacerse un hueco en nuestro PC.

NVIDIA

GeForce 4 MX (NV17 y NV18)

No cabe duda de que este chip ha supuesto todo un jaleo para muchos compradores, que han visto GF4 en el nombre y han pensado que era compatible DX8. Nada más lejos de la realidad: una GF4 MX es equivalente a una GeForce 2 Pro de antaño. Evidentemente es más que suficiente para los juegos de hoy en día y tiene un precio muy decente (algo más de 100 €), pero va a quedar fuera del mercado en cuanto los Xabre y Blade aparezcan.

Por otro lado, las GF2 MX (NV11), ya sólo se montan en ordenadores cuyos dueños vayan a jugar muy poco, pero eso no quiere decir que no sirvan para nada. Con un procesador potente, es factible jugar incluso a los últimos juegos, siempre que no pretendamos hacerlo con el Antialias activado.

Análisis ABIT Siluro GF4 MX 440

GeForce 3 (NV20)

La primera tarjeta en implementar Pixel y Vertex Shaders sigue siendo válida hoy en día, pese a llevar una sóla unidad de Vertex Shaders. Se pueden encontrar Ti200 nuevas por menos de 150 € y recordemos que estos chips son totalmente compatibles con DX8. Eso sí, no nos dará la misma potencia que tarjetas más caras, pero pueden ser una buena solución para los juegos de hoy y del año que viene, sobre todo con un procesador rápido.

Análisis Creative 3DBlaster GeForce 3

GeForce 4 Ti (NV25 y NV28)

Las Ti4400 van a desaparecer del mercado, dejando toda la responsabilidad para Ti4200 y 4600. Con la aparición del NV30 este Otoño es de esperar que los precios bajen mucho, pero en ningún caso conseguirán que la Ti4600 pase a costar lo que una Ti4400. Lo cierto es que las tarjetas de calidad con chips Ti4200 puede funcionar sin problemas por encima de las especificaciones de una Ti4400 y eso las hace particularmente interesantes. No obstante, recordemos que estas tarjetas (las de calidad) cuestan todavía unos 225 €.

Radeon 8500

Pese a que el chip de ATI empezó con problemas de drivers, no hay duda de que permitir que otros fabricantes produjesen tarjetas con estos chips ha sido una gran decisión. Esto ha permitido una espectacular bajada de precios (se habla de Radeon 8500 por unos 120 €), pero también una gran diversidad en cuanto a la oferta. Hay que saber exactamente qué chip es el que monta la tarjeta, porque además de los 8500 genuinos (275 MHz de core y memoria) y los LE (250 MHz), han aparecido sucedáneos mucho más lentos (y que en nuestros foros se conocen como LELE o aserejé).

Pese a la compatibilidad del Radeon 8500 con los Pixel y Vertex Shaders 1.4 (por encima de los de NVIDIA), en los tests con estas funciones las Ti4200 son bastante más rápidas. Pero claro, hay que tener en cuenta que cuestan bastante más dinero que las de la compañía canadiense.

Las Radeon 7500 casi se pueden dar por descartadas en esta guerra: su bajo rendimiento (superado por las GF4 MX) las hace poco atractivas. Eso sí, hay gran variedad de modelos (con muy diferentes velocidades de core y memoria y SDRAM y DDR) entre los que se puede encontrar uno que se ajuste a nuestro presupuesto.

En cuanto a las Radeon 9000, las sucesoras de las 8500, parece que van a tener algo menos de rendimiento (llevan el mismo número de motores de rendering, pero sólo una unidad de texturas por motor frente a las 2 del 8500), sólo que a ATI le va a costar mucho menos fabricarlas (y es de esperar que esto repercuta en el precio que tiene que pagar el usuario final). No olvidemos que deberían salir por el precio de las GF4 MX, pero conservando el soporte DX8 (pixel y vertex shaders).

Análisis ATI Radeon 8500

SiS Xabre

El último chip exclusivamente DX8 en llegar al mercado ha sido el Xabre de SiS, que pretende hacerles la competencia a las GF4 MX y Radeon 7500. Para ello, el fabricante de Taiwán ha optado por utilizar compatibilidad con Pixel Shaders por hardware, lo que hace que esta tarjeta pueda ejecutar y mostrar efectos DX8. Eso sí, los vertex shaders son por software, aunque los rendimientos publicados por diversas revistas extranjeras son muy interesantes (al nivel de las GF3 Ti 200), aunque siempre se hace referencia a que los drivers son un tanto inestables.

En cualquier caso, la familia Xabre nos ofrece chips para todos los bolsillos:

El Xabre 80 lleva core a 200 MHz y memoria SDR a 166, el 200 presenta velocidades de 200/166 (332 DDR) y el 400 de 250/250 (500 DDR). Todos son compatibles AGP 8X, menos el 80, que lo es con AGP 4X. Además, llevan motor T&L de tercera generación, soportan texturas volumétricas, bump mapping, cubic mapping, shadow mapping, llevan diversas optimizaciones para la memoria, implementan AA de bajo impacto en el rendimiento, etc, etc. Vamos, nada que envidiar a modelos de la competencia. De todas formas, todavía no hemos visto ninguna de estas tarjetas en España y se desconoce su precio.

En principio, ninguna. Yo esperaría a ver cómo bajan los precios de las Radeon 8500 con la llegada de las 9000. Y si realmente no te corre prisa, esperar a la salida de las NV30, que hará bajar los precios de las Ti4200. Sin embargo, tampoco conviene esperar mucho, porque los NV25 de NVIDIA pronto desaparecerán para dar paso a los NV28, cuya única novedad es el soporte AGP 8X. Eso hará que si no encontramos Ti4200 AGP 4X por haberse agotado, tengamos que ir a las AGP 8X, que nos costarán más caras. Seguro que os he dejado más confundidos que antes, pero es que no es nada fácil decidir cuándo comprar.

En cualquier caso, ya he comentado durante el artículo los precios de varias tarjetas con chips muy recomendables, donde la primera opción parece estar en las Radeon 8500 del fabricante Xelo y que varios lectores han comprado (podéis verlo en nuestros foros) por unos 120 €.

Si lo vuestro es NVIDIA, las GF3 Ti200 son ahora mismo muy asequibles (aunque tienen un rendimiento inferior al de las Radeon). Y si tenéis algo más de dinero, podéis ir a por las GF4 Ti 4200: rinden más que las 8500, pero también son bastante más caras.

En cuanto a los chips poco conocidos por estos lares, como los SiS Xabre, poco os puedo decir. No he visto ninguna tienda que venda tarjetas con estos chips y ni siquiera hemos podido probar ninguna (aunque nos hemos puesto en contacto con varios fabricantes extranjeros). Sólo os puedo decir que su rendimiento es del estilo de una GF3 Ti200, con un precio algo más bajo, pero que sus drivers parecen no estar suficientemente maduros.

Espero que con este artículo hayáis podido extraer vuestras propias conclusiones sobre el presente y el futuro inmediato de los chips gráficos. Y si tenéis alguna duda, preguntad, que para eso estamos...

Un último apunte: hasta dentro de muchos meses (quizá más de un año) no empezaremos a ver juegos con características DX9, salvo a lo mejor Doom III (que también funcionará en GeForce 4 y similares). Es posible que MadOnion saque un 3Dmark 2002 en torno a las fechas de aparición de las DX9 para poder demostrar lo que la nueva API hace. Y como siempre, ATI y NVIDIA lanzarán demos que nos dejarán asombrados de lo que puede hacer nuestra tarjeta, pero hasta que los juegos no hagan eso mismo, nos da igual (o debería).

Ya sabes: compra estrictamente lo que necesites. Ahora mismo hay cuatro juegos con características DX8 en el mercado. Si no te gusta ninguno de ellos, irás sobrado con una GF4 MX o similar. Eso sí, asegúrate de que todos los que esperas con ilusión vayan a funcionar sin tirones en tu tarjeta gráfica (aunque sea sin Antialias).