Siluro GF4 MX: el inconfundible estilo ABIT.

Ya conocemos lo que busca ABIT al diseñar sus placas base, altamente recomendadas para los overclockers. Pero la compañía taiwanesa busca también esta cualidad en su línea de tarjetas gráficas Siluro. Hoy analizamos el modelo con chip GF4 440MX.

Ya tenemos aquí los nuevos chips de NVIDIA, los GeForce 4 y GeForce 4 MX, así que todos los fabricantes que producen tarjetas con estos chips han empezado a lanzar sus productos, diferenciándose en poco unos de otros. Pero he aquí que ABIT ha querido destacarse del resto y ha lanzado su gama de GeForce 4 MX con ciertas características muy de agradecer, pero no nos precipitemos y sepamos un poco más del hermano pequeño del GF4, ya que es el que monta la ABIT Siluro que hoy analizamos.

Como ya sabréis muchos de vosotros, hay grandes diferencias entre los dos últimos chips de NVIDIA. Si bien el GF4 es totalmente compatible con DirectX8, la versión MX no, aunque sí incorpora ciertas características que le permiten portarse con soltura con los juegos de hoy en día. Nunca entenderé la política de nomenclatura de NVIDIA: ¿a qué viene llamar GF4 MX a un chip que no es superior al GF3?

| Llama la atención el PCB de color azul |

Además de las optimizaciones de memoria que implementan los GF3 y 4 (LightSpeed Memory Architecture aunque de dos segmentos, Compresión del Buffer Z,...), el GF4 MX es el único chip de NVIDIA (por el momento) que lleva el VPE o Video Processing Engine. Este grandilocuente nombre no es otra cosa que el soporte total por hardware para la descompresión MPEG-2, incluyendo iDCT y compensación por movimiento, dos cosas que ATI incorpora en sus tarjetas desde hace tiempo.

Aparte de estas características, tanto el GF4 como el MX llevan dos RAMDAC de 350 MHz, permitiendo (por fin) salida simultánea a dos monitores o monitor y televisor sin preocuparse de las diferencias de refresco entre ambos dispositivos de salida. Otras cosas interesantes son el Accuview (un método de antialiasing mejorado) el empaquetado BGA para los chips de memoria, que permite una mejor difusión del calor y que el chip está fabricado con tecnología de 0.15 micras.

| /es/node/Array |

| Parte inferior de la tarjeta |

Como suele hacer NVIDIA con sus últimos lanzamientos, dentro de la familia GF4 MX hay diferentes productos, llamados 420, 440 y 460, y que se diferencian únicamente por las diferentes velocidades de core y memoria. El más económico, el 420, da un fillrate de 1000 Mtexels/s y un ancho de banda de 2.7 GB/s debido a que incorpora memoria SDRAM. El siguiente, el 440, da 1100 Mtexels y 6.4 GB/s (memoria DDR a 400 MHz), mientras que el 460 da 1200 Mtexels y 8.8 GB/s (memoria DDR a 550 MHz).

Es lógico pensar que los chips GeForce 2 MX van a pasar a mejor vida con la introducción de estos nuevos productos, ya que los GF4 MX no pretenden competir con las GF3/GF4 (más que nada, por la carencia de soporte DX8), sino que vienen a reemplazar a estos chips, e incluso a los GF2 GTS/PRO/Ultra y GF2 Ti. El GF4 MX 420 vendría a sustituir al GF2 MX200, mientras que los dos modelos con memoria DDR podrían reemplazar a MX400 y diversas variantes de GF2 'puras'.

Pero seguro que todo esto ya lo sabíais y lo que estáis deseando ver es qué tal se porta una tarjeta con alguno de estos chips en los benchmarks, ¿verdad? Pues todavía no os lo voy a contar, porque lo primero es abrir la caja de la ABIT Siluro GF4 MX 440 que hemos recibido.

El Hardware

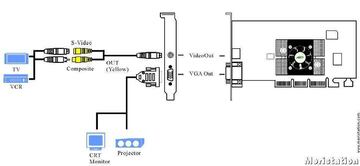

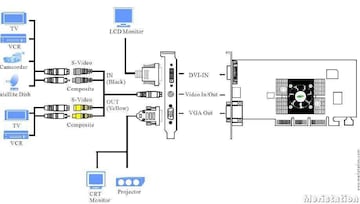

La tarjeta de ABIT que hoy tenemos la suerte de analizar se basa en el chip GF4 MX 440 (cosa que ya habréis deducido por su nombre), al igual que el modelo VIO del mismo fabricante. La única diferencia entre ambas es que la VIO puede capturar vídeo (tanto compuesto, como SVHS como DVI). Como podéis ver en estos dos diagramas (extraídos del manual de la tarjeta que analizamos), a nivel de conectores, la única diferencia entre ambos modelos es el conector DVI.

| Diagrama de conexiones GF4 MX |

Sin embargo, en el caso de la VIO, los conectores que hacen de salida hacen también de entrada. Se puede apreciar también que la clavija al lado del D-Sub 15 para VGA es propietaria y no S-VHS. ¿Por qué? Pues porque en la caja de las tarjetas podremos ver un latiguillo que se conecta a esta clavija propietaria y que suministra los dos conectores (compuesto y SVHS) que podríamos necesitar.

| Diagrama de conexiones GF4 MX VIO |

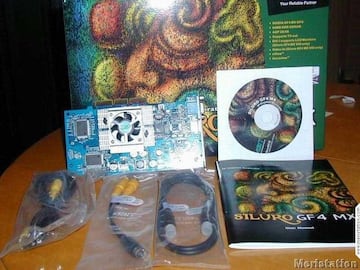

Además de este adaptador, tenemos también un cable SVHS y otro RCA, con lo que no tendremos que ir a ninguna tienda para poder empezar a ver el escritorio del Windows en nuestro televisor, pero ya hablaremos más adelante de esto.

| La versión retail incluye cables para todo |

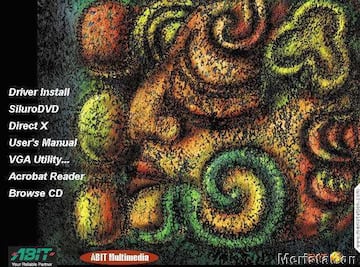

Dentro de la caja, encontraremos también un manual con abundantes explicaciones de todo tipo sobre las diferentes pestañas de los drivers y otras cosas más, con la calidad que siempre ha mantenido ABIT. Eso sí, está en inglés. Lo último que hay dentro de la caja es un CD con los Detonator 27.30 y software variado. Cabe destacar el SiluroDVD (para ver DVD), el 3Deep (para mejorar el contraste en los juegos) o el Graphic MAX (utilidad de overclocking).

| Todo lo que incluye la versión retail |

Ya hemos visto lo que se incluye en el paquete, pero vamos a examinar la superficie de la tarjeta detenidamente. El diseño está basado en el de referencia de NVIDIA, con dos chips por cada lado de la tarjeta, de marca Samsung y de 4 ns. Este es otro de los detalles que me han gustado, porque otros fabricantes están montando en sus tarjetas chips de 5 ns, por lo que la Siluro parte con una clara ventaja para el overclocking, al menos a priori. En cuanto al disipador, de atractivo diseño, es de generosas dimensiones y es otro indicio más de que esta tarjeta está muy preparada para soportar frecuencias de funcionamiento que excedan las especificaciones de NVIDIA.

| Un primer plano del enorme disipador |

El resto de las características las podéis ver en la web de ABIT.

Instalación y nView

Instalar la tarjeta fue cosa de niños: se saca de la caja, se pincha en el AGP y se enciende el ordenador. Los Detonator que tenía instalados, los 23.11, no detectaron la tarjeta, así que instalé los que venían en el CD-ROM, etiquetados como 27.30. Una vez que la tarjeta estuvo instalada, lo primero que quería probar era una de las nuevas características de los chips GF4: el nView. Así que con el latiguillo suministrado, un cable SVHS, un adaptador a Euroconector y un vídeo del año de la polka conectado mediante el cable de antena a mi capturadora de TV, hice una prueba que más parecía una escultura abstracta.

| El latiguillo para Vídeo Compuesto y SVHS |

De la Siluro salía el cable SVHS que estaba conectado al vídeo gracias al adaptador a Euroconector mientras que de dicho vídeo salía un cable coaxial a la entrada de antena de mi capturadora de TV. Los drivers de la tarjeta detectaron este segundo dispositivo de salida y me permitieron configurarlo de manera totalmente independiente del monitor, pudiendo ponerlo a 1024x768 con total tranquilidad. Una vez hecho esto, lancé el programa para ver la televisión sintonizado en el canal del vídeo y el resultado fue el que podéis ver en la siguiente foto.

| El adaptador de SVHS a Scart |

Pues sí: por fin un chip NVIDIA es capaz de mostrar la misma imagen en dos dispositivos de salida diferentes simultáneamente. Eso sí, como el monitor estaba a 1280x1024 y la televisión a 1024x768, el escritorio no cabía entero en esta última, por lo que había que desplazar el ratón hasta el borde para poder ver el resto del escritorio, a la manera de los escritorios virtuales de otras marcas. Y otra cosa que no me ha gustado es que la pantalla del televisor no se aprovecha al máximo: queda un recuadro negro alrededor de la imagen tomada del ordenador. Aún así, se puede grabar un vídeo de algún juego en una cinta VHS con una calidad muy decente, mucho mejor que la que veis en la foto, porque la señal de antena que entra en la capturadora lleva mucho ruido.

| Una muestra del nView |

En cuanto las posibilidades que ofrece esta características, pues en Windows 98 son bastante limitadas, porque sólo podemos tenerla desactivada o en modo clon, es decir, mostrar lo mismo en los dos dispositivos de salida. En cambio, con los drivers de Windows 2000/XP, se puede distribuir el escritorio horizontal o verticalmente entre sendos dispositivos.

Pero pasemos a los benchmarks. Lo primero, el equipo de pruebas.

ABIT KG7-RAID

Athlon 1.33 GHz (266)

2x256 MB DDR Hyundai

SB Live! Value

Capturadora BestBuy

Controladora SCSI Advansys

Tarjeta de red con chip 8029AS

Disco duro Seagate Barracuda IV 20 GB UDMA 100 7200 rpm (Primario Maestro)

Disco duro Fujitsu MPA3035U 3.5 GB UDMA 33 5400 rpm (Primario Esclavo)

Disco duro Quantum Maverick 512 MB PIO 4 (Secundario Esclavo)

Lector CD-ROM Plextor Ultraplex 40Xmax SCSI

Grabadora CD-RW Plextor Plexwriter 12/10/32A (Secundario Maestro)

Windows 98 SE

DirectX8.0a

AMD AGP Driver

VIA 4in1 v.4.37 (solo para el USB)

Detonator 27.11 personalizados por ABIT (incluidos en el CD de la GF4 MX)

Las tarjetas gráficas que aparecen en las gráficas son dos modelos de ABIT: La Siluro T400 (que lleva un GF2 MX400 con 64 MB de SDRAM a 166 MHz) y la GF4 MX que estamos analizando, ya que se supone que ésta es la sustituta de la primera. Las pruebas se hicieron teniendo residentes en memoria únicamente los drivers de mi ratón óptico (IntelliMouse 4.0) y con el PC recién arrancado. Se escogieron los Detonator 27.11 porque me gusta probar la tarjeta con los drivers que incluye, eso da una idea de lo que el comprador puede ver en su PC nada más probar el producto. Que tengas que descargarte los drivers por Internet nada más comprar una tarjeta me parece la leche, por no decir algo más fuerte, y es imposible que te den en CD los últimos. Incluso mientras escribo este artículo es posible que ya haya drivers más modernos que los 27.70 (últimos de los que tengo noticias).

Una cosa más sobre los drivers incluidos en el CD: están en completo castellano e incorporan nView, cuya principal utilidad es el poder tener varios escritorios simultáneamente, al estilo de X-Window, aparte de niveles de zoom y otras cosas muy prácticas.

| El menú principal del CD de drivers |

El caso es que la metodología de las pruebas fue la siguiente: cogí mi PC (equipado con la Siluro T400 con los drivers 23.11 de NVIDIA) y pinché la GF4 MX a lo bruto, sin anestesia ni nada. Estos Detonators no reconocieron la nueva tarjeta, así que instalé los del CD encima (sin desinstalar los antiguos, ni formatear, ni nada), para ver si daba problemas o alguna cosa similar. Nada: todo fue perfecto y las puntuaciones obtenidas así lo atestiguan. Tras hacer todos los tests con la GF4 MX, volví a pinchar la MX400 con esos mismos Detonators y hala, a correr otra vez todos los tests. Esto se hizo así por dos razones: para hacer todo lo más rápido posible y para no falsear resultados. El procedimiento que he descrito es el que todo comprador de una nueva tarjeta seguiría nada más llegar a casa de la tienda, consumido por la impaciencia y deseando que el dinero que ha desembolsado esté perfectamente justificado. Pero me estoy enrollando, veamos los benchmarks.

Direct3D

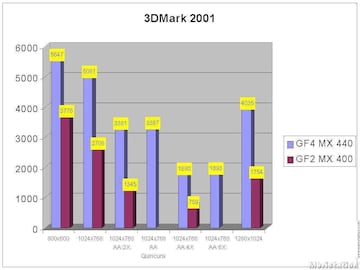

Empezamos por el clásico 3DMark 2001 estándar (no el SE). Si bien la GF4 MX fue detectada como Pure Hardware T&L (como las GF3), no pasó ninguna de las pruebas que implican el uso de Píxel Shaders (Nature, Píxel Shaders) ni de Environment Bump Mapping. Este resultado era de esperar, porque la GF4 MX no implementa el motor nFinite, por lo que no lleva ni Píxel ni Vertex Shaders.

| Resultados 3DMark 2001 |

El test por defecto ya da una idea del potencial de esta tarjeta, duplicando casi la puntuación de la GF2 MX400. Más aún: incluso con el antialias a 2X o Quincunx, la GF4 MX saca 600 puntos más que la MX400 sin antialias. También es reseñable que el rendimiento es casi idéntico con AA 2X que con Quincunx (modo que no está disponible en la MX400), siendo de mejor calidad este último, como ya sabréis. También se puede ver que con el AA de seis muestras (nuevo en esta tarjeta, aunque sólo disponible para D3D), se obtiene una puntuación mayor que con el de cuatro. La calidad es similar en ambos casos, sólo apreciada en imágenes estáticas con muchos ángulos.

Tanto a 800x600 como 1280x1024, la historia se repite y como era de esperar, a mayor resolución, más diferencia hay entre las dos tarjetas. Tengamos en cuenta que, pese a tener ambas 64 MB, en un caso se trata de DDR a 400 MHz, mientras que en el otro es SDR a 166. También hay que recordar que la tarjeta más moderna lleva Light Speed Memory Architecture II, optimizando el uso de la RAM más aún.

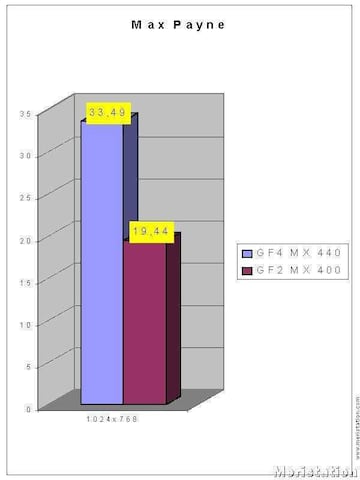

| Resultados Max Payne |

| Configuración Max Payne |

Y aquí los resultados, simplemente a título representativo, donde se ve cómo la GF4 MX domina claramente a su predecesora.

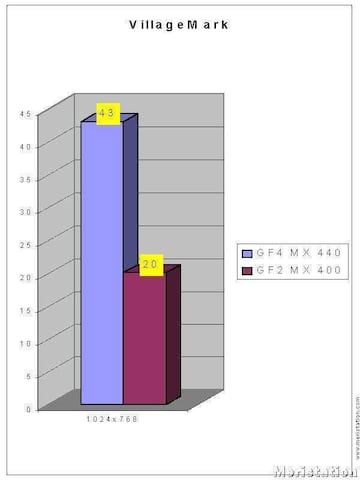

Por curiosidad, también pasamos el benchmark 2 de VillageMark, famoso por poner al límite las capacidades de detección de polígonos ocultos de cualquier tarjeta. Lo ejecutamos a 1024x768x16 bits y obtuvimos más del doble de rendimiento entre las dos tarjetas, fruto de una memoria más rápida y de las optimizaciones que incorpora el nuevo chip para el tratamiento de superficies ocultas. Como referencia, con una Kyro II en un Pentium III 866 se obtiene una puntuación de 76, demostrando que a NVIDIA todavía le queda camino por recorrer para solucionar el tema del overdraw de polígonos.

| Resultados VillageMark |

OpenGL

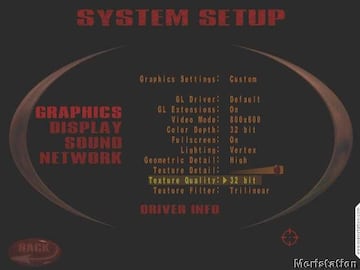

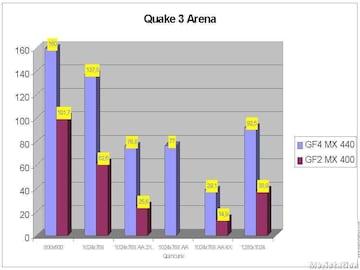

Pasemos a los tests en OpenGL. El primero de ellos es el mítico Quake 3 Arena, sin parches de ningún tipo y con la configuración que veis aquí, para la Demo 1.

| Configuración Quake 3 Arena |

| Resultados Quake 3 Arena |

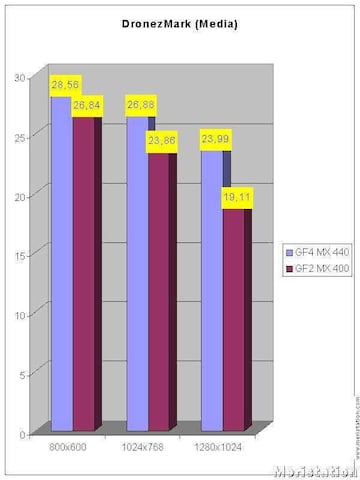

| Configuración DronezMark |

| Resultados DronezMark |

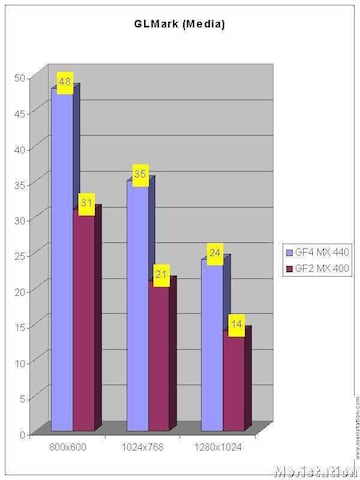

Por último, ejecutamos GLMark con la siguiente configuración:

| Configuración GLMark |

| Resultados GLMark |

Overclocking

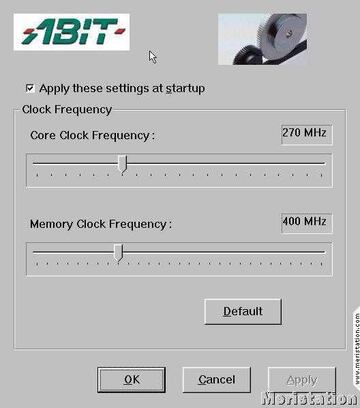

La velocidad por defecto de la tarjeta es de 270 MHz para el core y 400 MHz para la memoria. Ya que la tarjeta incluye un programa para poder ajustar estos valores, vamos a usarlo para trastear con ellos, siempre teniendo en cuenta que los máximos que permite son de 340 MHz para el chip y 500 para la memoria.

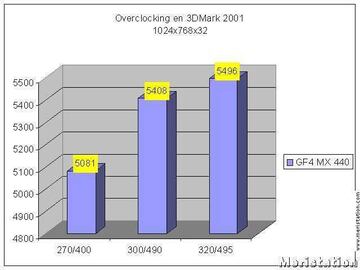

Lo primero que hicimos fue probar la combinación 300/500, pero fue sin éxito: no llegaba al tercer test del 3DMark 2001 (el de Dragothic), así que nos decidimos por algo más conservador, poniendo la tarjeta a 300/490. Esta vez la cosa fue mucho mejor: todo el 3DMark 2001 pasado exitosamente y sin efectos extraños en las texturas. Por último, probamos a 320/495, con lo que la tarjeta también pasó todos los tests, aunque en las pruebas de Bump Mapping, se veían algunos colores fuera de lugar en las texturas.

| Uno de los chips, de 4 ns |

Parece que con esta memoria de 4 ns, lo máximo alcanzable sin problemas es 490 Mhz, pero el core parece aguantar mucho más que los 270 MHz de fábrica gracias al enorme disipador que monta. Daos cuenta de que a 320, estamos excediendo en 50 MHz la velocidad por defecto, casi un 20 % de este valor. En fin, veamos los resultados del test por defecto (1024x768x32) del 3DMark 2001.

| GraphicMAX, el programa de overclocking incluido |

| Resultados overclocking en 3DMark 2001 |

Conclusiones

Primero, hablemos del chip de NVIDIA. No hay duda de que el GF4 MX 440 es un gran chip, pese a no implementar píxel ni vertex shaders. Es más rápido que un GF2 Ti (que tiene un precio similar) gracias a la mayor velocidad de core , pese a que sólo tiene dos motores de rendering frente a los cuatro de su antecesor. Como era de esperar, también le da cien vueltas al GF2 MX400, el chip al que viene a sustituir, pese a que con un procesador rápido (a partir del GHz), sigue funcionando perfectamente en la inmensa mayoría de los juegos actuales. Por tanto, entre estos tres chips, el claro vencedor es el GF4 MX440, aunque tiene un precio bastante superior al GF2 MX400, el rendimiento aumenta espectacularmente.

Sería tontería comparar esta tarjeta con las GF3, porque no está pensada para ello. Muchos lectores han mencionado que en ciertos tests, las GF4 MX 440/460 superan a las GF3 Ti200, pero es lógico, dada la mayor velocidad del nuevo chip. Pero como se ve en las pruebas de DronezMark, el rendimiento queda a la altura de una GF2 MX400 en cuanto tiene que acudir al software para renderizar cosas que en las GF3 van por hardware. Pero claro, estas características todavía no se usan, y en mi humilde opinión, aún falta para que las veamos en todos los juegos. Así que si vas a montar un ordenador nuevo para jugar, este chip es perfectamente válido, pero siempre que tengas en cuenta que cuando las DX8 imperen, habrá que comprarse otra tarjeta.

Para los que quieren ampliar su ordenador, está claro que el pasar de una GF2 MX a este chip es una buena decisión, pero que depende claramente del capital disponible, ya que se pueden encontrar GF3 Ti200 por un poco más de presupuesto y estas tarjetas sí que son compatibles con DX8.

Me he quedado con ganas de probar la reproducción de DVDs con esta tarjeta, pero prometo hacerlo cuando consiga un lector de este formato. Supongo que si con las GF2/3 ya se veía muy bien, si encima usamos la aceleración total por hardware, la calidad aumentará, pero quiero probarlo en cuanto pueda.

En cuanto a la salida multi-display, la verdad es que ya era hora de que NVIDIA implementase esta característica en sus chips, sin tener que montar chips de Chrontel o Phillips. Además, antes esta salida no era simultánea: no podíamos ver a la vez el escritorio del Windows en el monitor y en la TV. Ahora sí es posible y con muy buena calidad (salvo el recuadro negro que aparece alrededor en la TV y que espero que se corrija en posteriores drivers).

Ahora hablemos de la tarjeta de ABIT en particular. Si bien otros fabricantes incluyen juegos o demos en sus productos, ABIT prefiere otros argumentos para vender sus tarjetas: la calidad de sus componentes. Eso se nota nada más sacar la tarjeta de la caja y ver el atractivo e inmenso disipador que cubre el GF4 MX440 y los chips Samsung de 4 ns. Por supuesto que la tarjeta funciona a la perfección con todos los juegos de hoy en día (una gozada Return to Castle Wolfenstein a 1024x768x32 con antialiasing Quincunx, con una fluidez pasmosa), pero si encima overclockeamos la tarjeta, el rendimiento aumenta proporcionalmente. Y en todo momento con una estabilidad de hierro, gracias a la calidad de los componentes

Para que os hagáis una idea, el modelo de MSI, por ejemplo, lleva chips de 5 ns, y un disipador más pequeño, aunque incluye varios juegos y demos. En vuestras manos queda el decidir qué valoráis más al comprar una tarjeta: si el software o la capacidad de overclocking. Yo tengo en cuenta más esto último, así que la Siluro GF4 MX sería mi elección en principio, a falta de ver los modelos de otros fabricantes..