GeForce 4. Ante todo, variedad...

Ante la avalancha de productos GeForce 4 a la que nos enfrentamos, qué menos que hacer un pequeño repaso por las seis tarjetas que NVIDIA nos propone. Porque una cosa está clara, entre las GeForce 4 más que nunca, tenemos que saber qué es lo que compramos...

Resulta muy fácil acostumbrarse a lo bueno, lo cual queda demostrado con la normalidad con que aceptamos que NVIDIA cada año nos proponga una nueva revolución en el hardware gráfico. Prácticamente, a principios de año ya conocemos el calendario que nos espera

Nuevo y revolucionario chip en primavera

versión económica del mismo en verano

y el tope de la gama apuntando al invierno, bien situado para la campaña navideña

Pues bien, será porque éste es el año capicúa del siglo o porque definitivamente NVIDIA cambia de política de lanzamientos, pero los próximos lanzamientos de NVIDIA poco tienen que ver con lo que hasta ahora había convertido en habitual. Si tuviéramos que buscar un 'culpable' de estos cambios, la mayoría de los dedos apuntarían a los de siempre a los grandes -¿únicos?- enemigos de NVIDIA; los canadienses de ATi. Veremos por qué

Para empezar esta vez no se presenta el chip e inmediatamente la primera tarjeta en montarlo, sino que se presenta toda una gama de tarjetas con 'targets' u objetivos de mercado distintos y muy bien definidos. Mejor dicho, se presentan dos gamas de productos que en realidad poco tiene que ver entre sí, de no ser que tienen el mismo nombre. Estas gamas adoptan el sistema de numeración creciente para dar a entender más fácilmente la potencia del producto respecto a sus hermanos de gama. Así, ya no tendremos las 'MX', 'PRO', 'Ultra' y demás variaciones, sino que veremos números como el 4200, 4400, 4600

Y por último, y como cambio más significativo, NVIDIA empieza a 'reintroducir' en el mercado productos propios, con un par de añitos, y con un lavado de cara importante, tal como ya hizo Power VR con las Kyro 3d o más recientemente ATi con las Radeon 7500

Tanta variedad en la oferta con tanta diferencia en los precios y con unas diferencias en hardware y rendimientos tan abismales, no pueden provocar menos que desconcierto en cualquier usuario que se presente en la tienda sin haberse estudiado bien la lección. En las siguientes páginas vamos a describir uno a uno los productos que NVIDIA nos propone, situándolos a cada cual donde le corresponde

Entre el 2 y el 4 y no es el 3

Adivina adivinanza Está entre el 2 y el 4 y no es el 3 ¿Qué es?... Pues según NVIDIA, el MX Vamos a empezar a hablar del GeForce 4 empezando desde 'abajo', desde el producto más sencillo y económico de la gama: las GeForce 4 MX. Más adelante hablaremos de las Titanium que, como ahora veremos, son las GeForce 4 'de verdad'.

La forma más sencilla de saber de qué estamos hablando, es usar la 'denominación técnica' de los chips gráficos de NVIDIA. Nos quedamos con que el nuevo GeForce 4 es denominado NV25, el GeForce 3 es el NV20, el GeForce 2 es el NV15 Y el 'nuevo' GeForce 4 MX es el NV17 Y ese es su lugar natural; entre el GeForce 2 y el GeForce 3, entre el NV15 y el NV20, a gran distancia del NV25

Usando esta nomenclatura técnica de los chips, la posición en la gama GeForce - a partir de ahora lo abreviaremos como GF - de las nuevas GF4 MX, está clara. El problema es que este nombre técnico no sale al mercado, sino que lo hace el nombre comercial, siendo de este modo una GF4, igual que las NV25 respecto a las que ofrece unas enormes diferencias. Pensad si es tal la diferencia que cuando hablamos de una GF4 MX hablamos realmente de un chip GF2, hardware que se presentó al mercado a comienzos del año 2000, mucho antes de que NVIDIA 'estandarizara' su tecnología de 'shaders' -pixel shader y vertex shader- y de que se adoptaran los DirectX 8, para los cuales NO cuenta con soporte.

Sabiendo lo anterior, llegamos a la primera 'gran conclusión' sobre las GF4: A precios similares, resulta mucho más interesante comprar cualquier GF3 que cualquiera de las GF4 MX. Sencillamente porque las GF3 cuentan con soporte para funciones que la propia NVIDIA vende como imprescindibles que las GF4 no tienen.

No obstante tampoco es cierto que las GF4 MX sean unas simple GF2 en una caja distinta. Si bien no hay tantas diferencias como las existentes entre GF2 y GF3, podemos apreciar las diferencias entre una GF2 MX 400 de hace un año con toda la gama de nuevas GF4 MX, tanto en el hardware como en el software o funciones soportadas. Si empezamos con lo más evidente, el hardware, veremos cómo mientras los GF2 estaban fabricados con tecnología de 0.18 micras, los GF4 MX lo están en 0.15 micras, lo cual implica unas mayores velocidades de 'core'. En la siguiente tabla vemos las diferencias entre una 'clásica' GeForce 2 MX400 y las nuevas GF4 MX.

Como vemos, las diferencias en el hardware existen, si bien es evidente que no justifican la diferencia de precios. Sin embargo quizá sí que la justifique las innovaciones que se han hecho sobre el 'soft-code'. Las GF4 cuentan con varias funciones que innova el NV25 -GeForce 4- y que abren una notable diferencia respecto a las GF2. Estás diferencias se centran en la efectividad a la hora de hacer antialiasing a pantalla completa -Accuview Anti Aliasing- y a la hora de aprovechar la memoria - Light Speed Memory Architecture II-. Además, las GF4 MX incorporan el denominado nView, que no es otra cosa que la posibilidad, mediante dos RAMDAC de 350 MHz, de utilizar dos monitores simultáneamente con la misma VGA.

Sin embargo, para algunos la diferencia más grande entre GF2 y GF4 MX será el soporte por hardware para la descompresión y reproducción de archivos MPEG2 -DVD-, que hasta ahora era la carencia que más ruborizaba a NVIDIA frente a ATi. Hablamos del VPE -Video Processing Engine-, una función exclusiva de las GF4 MX que permite compensación de movimiento e iDCT por hardware, o lo que es lo mismo, reproducción de películas DVD por hardware. Tales funciones han sido ofrecidas por los productos de ATi o incluso S3 desde hace años y cada vez era menos entendible que NVIDIA no los incluyera. Por fin lo ha hecho, aunque por lo que hemos podido observar en los foros americanos, la calidad ofrecida está muy lejos de la alcanzada por productos ATi.

Sobre las novedades en cuanto a funciones de los chips GeForce 4, hablaremos en las páginas posteriores, cuando describamos la verdadera joya de NVIDIA para esta temporada: Las GeForce IV Titanium, o NV25

GeForce 4 Titanium.

Podríamos subtitular el artículo como 'GF4 Titanium; el verdadero GF4', si bien ya hemos comentado que las GF4 MX también innovan y son en sí mismas un nuevo producto, el titular no sería del todo desacertado. El chip NV25 es claramente superior a su antecesor innovando técnicamente y sacándole una notable ventaja en rendimientos. Para comprobarlo, echemos un vistazo a la siguiente tabla

Vemos cómo aunque el tope de la gama, la Ti 4600, representa un gran avance respecto al actual tope, la Ti500, el resto de las opciones no lo son. La nueva política de lanzamientos de NVIDIA nos ofrece casos curiosos como la GF4 Ti 4200, una tarjeta a caballo entre las Ti200 y las Ti500 pero a la que le basta enseñar el precio para convencer a cualquiera. Podríamos tacharla de 'producto fratricida', ya que su simple entrada en el mercado hará desaparecer de un plumazo a las Ti 500. No queremos pensar en aquellos usuarios que acaben de invertir sus ahorros en este producto o en los distribuidores que se vean 'atrapados' con un stock importante de 'las viejas Titanium'

Marcando diferencias

Un breve vistazo a la tabla anterior nos hace levantar una ceja y mirar con desconfianza a las nuevas GF4. El hardware es 'demasiado parecido' al diseñado para el chip anterior, lo cual no hace suponer unas grandes diferencias de rendimiento. Sin embargo, en cuanto hagamos unas cuantas pruebas de rendimiento, veremos cómo las suposiciones son equivocadas. Aunque mediante hardware bruto no se puedan marcar grandes diferencias, las innovaciones en cuanto a funciones 3d, optimización del uso de los recursos y algunos 'trucos' en el software, sí lo consigue. Y así lo anuncia NVIDIA, manteniendo el discurso del lanzamiento del GF3 Ya no se busca la potencia bruta, alcanzar el máximo de fotogramas por segundo Ahora se busca plasmar la realidad en una pantalla con la máxima fidelidad. Se apuesta por mejorar los filtrados, el tratamiento de luces, la gestión de superficies visibles y no visibles En definitiva el nFinite FX II

nFinite FX II

Hace aproximadamente un año analizábamos la primera GeForce 3, la Hercules 3d Prophet III y descubríamos su más importante aportación al panorama 3d del momento, la tecnología nFinite FX, lo cual podríamos definir como la posibilidad de programar el propio chip GeForce, la GPU, para que hiciera aquello que el programador gráfico imaginase. Con esta tecnología las posibilidades para el programador se multiplicaban. Conocíamos entonces el Píxel Shader y el Vertex Shader tecnologías que, según NVIDIA, serían la base de la programación 3d a medio plazo

/es/node/ArrayHoy, con el GeForce 4, NVIDIA nos presenta la revisión de la tecnología nFinite FX, a la que ha bautizado con el original nombre de nFinite FX II. Si en su día aprendisteis cuál era la función de esta tecnología qué hacía el píxel y el vertex shader entonces sabes perfectamente lo que hace esta nueva versión. En resumidas cuentas hace exactamente lo mismo que la primera, pero mejor. La diferencia fundamental es que se ha añadido una segunda unidad vertex shader, con lo que doblamos la capacidad del chip a la hora de tratar polígonos. Si a esta circunstancia sumamos el aumento de las frecuencias de las nuevas GF4 respecto a las GF3, podríamos decir que tal capacidad casi se triplica. Además de esta mejora evidente, NVIDIA afirma que se ha optimizado la forma de trabajar tanto de los píxel shaders como de los vertex shaders, algo de lo que nos tendremos que fiar apoyándonos exclusivamente en test como el 3d Mark 2001 SE, quizá el único software capaz de demostrar si realmente esto es así.

Lo mismo ocurre con los píxel shaders. Las GF4 incorporan la versión 1.3 de esta tecnología, superior a la 1.2 de las GF3 pero sin llegar a la 1.4 que mantienen en exclusiva las Radeon 8500 de ATi. Además de una mayor velocidad, el nuevo píxel shader de las GF4 incorpora la función de Bump Mapping con corrección-Z, una efectista opción de bumb mapping destinada a mostrar con realismo texturas que se extienden sobre otras superficies distintas e irregulares, como un charco de agua sobre el césped o cualquier otra sustancia o tejido que se amolda a una superficie irregular.

Como hemos comentado, aunque NVIDIA haga especial hincapié en estas nuevas innovaciones del nFinite FX, a nosotros no nos parecen tan importantes, en tanto no podemos disfrutar de sus ventajas a no ser que lo hagamos en el citado 3d Mark 2001 SE o las propias demos de NVIDIA. Por el momento ningún otro software -juegos- las aprovecha. De ahí que nosotros valoremos mucho más las siguientes innovaciones; el Accuview, LMA II, nView

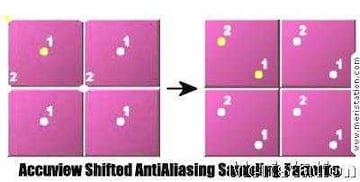

Accuview; AntiAliasing a pantalla completa.

Al fin Desde que las extintas Voodoo apuntaron la primera tecnología de antialiasing a pantalla completa, hemos soportado distintas técnicas para eliminar los molestos 'jaggies' o dientes de sierra que aparecen en los juegos 3d en resoluciones medias y bajas. Tanto NVIDIA como ATi nos han ofrecido sus apuestas por hacer la escena más real hemos aprendido palabrejas como Quincunx, HRAA Todo muy bonito hasta que lo aplicábamos a un juego real. El impacto en los rendimientos era tal que la práctica totalidad de los usuarios prescindía de del AntiAliasing en pos de una mayor jugabilidad. Pero todo eso parece que llega a su fin. Al fin hemos podido correr un juego con el máximo filtrado antialiasing sin perder la mitad de los rendimientos. La 'culpa' la tiene el Accuview, una nueva técnica de filtrado que, acercándose de nuevo a las propuestas de ATi, consigue que el impacto en los rendimientos se limite a un 15 ó 25%. Podríamos hablar durante largas páginas sobre esta técnica, pero es preferible que tratemos otros apartados, dado que NVIDIA lo explica a la perfección en su web y lo que a nosotros nos interesa ya está dicho: realmente funciona.

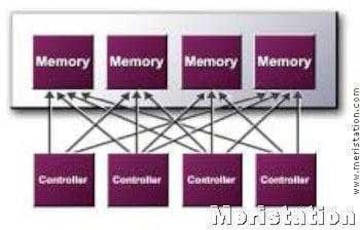

LMA II: Light Speed Memory Architecture.

Personalmente la nueva arquitectura de memoria que presentó NVIDIA con su GeForce 3 me pareció su mejor aportación. El uso inteligente de la memoria era algo tan sencillo de aprovechar como efectivo y NVIDIA había tardado demasiado en darse cuenta. El GF4 nos trae la optimización de aquella tecnología. La arquitectura LMA II se basa en una serie de funciones cuya combinación revierte en un notabilísimo aprovechamiento de la memoria, con los consecuentes aumentos en el rendimiento. A continuación repasaremos brevemente todas estas funciones

Crossbar Memory Controller: Como vemos en el gráfico, son cuatro los controladores que gestionan la memoria. Podríamos decir que la capacidad total de la memoria se divide en cuatro porciones que son gestionadas independientemente para lograr liberar el mayor ancho de banda posible.

Quad Cache: Es de suponer que cualquiera de nosotros sabemos que la memoria caché es una memoria extremadamente rápida destinada a ser utilizada con las operaciones más usadas o que más interesa acelerar. El buen aprovechamiento de la memoria caché, así como la cantidad de la misma, son fundamentales a la hora de buscar altos rendimientos. Eso piensan también en NVIDIA y han dotado a las GeForce 4 Ti de porciones de memoria caché destinadas a funciones como el 'dibujado' de polígonos o texturas repetidos. Concretamente los cachés son: Caché de vértices, caché de píxeles, caché primitivo y caché de dobles texturas

Lossless Z-Buffer Compression: Algoritmo de compresión que ya usamos en las GeForce 3. En las 4, la compresión es aún más efectiva.

Z-Occlusion Culling: La conocida eliminación de superficies ocultas que hizo triunfar a las Kyro y que tan bien hacen las Radeon. Por supuesto, esta versión es más efectiva que la que usan las GF3 -o eso promete NVIDIA-.

Fast Z-Clear: Otra aportación de las Radeon de ATi. Se basa en la selectiva eliminación de información residual del Buffer-Z.

Auto Pre-Charge: Encargado del mejor aprovechamiento de la memoria DDR. Simplifica el acceso a la información de la memoria organizando su situación dentro de la misma.

nView:

NVIDIA se dispone a acabar con las ventajas que hasta ahora le separaban de otros fabricantes. Podemos ver en el nView un ataque directo a la gran ventaja de Matrox, el aprovechamiento de dos monitores simultáneamente. Con nView podremos conectar dos monitores, analógicos o digitales, planos, combinaciones de monitor y proyector, sin importar las resoluciones y de una forma aparentemente muy sencilla. Para ello, todas las GF4 cuentan con dos RAMDACs de 350 MHz y un montón de software ajustado a las necesidades tanto de jugadores como a profesionales

GeForce 4; espacio para la polémica.

Cuanto más grande es un gigante, menos desapercibido pasa su avance. Eso es lo que ocurre con NVIDIA. Cada movimiento suyo es examinado escrupulosamente e inmediatamente inunda foros y listas de correo. Con el GF4 se han disparado las suspicacias. Y pensamos que con razón

Para empezar, la llegada de tantos productos desconcierta. No el hecho de que se lancen muchas tarjetas, sino que se haga de esta forma, de modo que un producto anula al otro. Por descontado, nadie con un mínimo de conocimiento y aprecio a su cartera va a comprar una GeForce III Ti500. Cualquier GF4 Ti le da un baño e incluso costando mucho menos. Eso también explica otra parte de la polémica Las GeForce 4 llevan disponibles desde hace largos meses, pudiendo haber estado perfectamente presentes en el mercado en la pasada campaña de Navidad. Son estos meses los que se le ha concedido de 'gracia' a las GF3 Titanium

La polémica de los lanzamientos sigue por su denominación ¿No había otra forma de denominar a las GeForce 4 MX? ¿Tan sencillo es este mundillo que nos podemos permitir juegos de nombres de este tipo? Es más ¿tal es el avance de las GF 4 para merecer ese nombre? ¿no podría haber sido otra variación de las GF3? Muchos así lo piensan, apuntando que las innovaciones no son más que la optimización de las funciones ya mostradas en la arquitectura del GF3 También se podría hablar de la optimización del hardware mediante software. Si ahora se nos vende un GF2 tan optimizado como dicen ¿no es posible mejorar de algún modo nuestra GeForce II Ultra que casi nos arruina?...

Y ya si hablamos de software, entraríamos en la vieja polémica de para qué necesitamos tal o cual función que no se va a aprovechar hasta dentro de muchos meses -¿años?-. Si en teoría la GF4 centra sus principales avances en el añadido de un segundo vertex shader ¿de qué nos sirve si aún no usamos ni el primero?...

¿Y la propia existencia de las GeForce 4 MX?... Sin duda gran parte de su objetivo está en el mercado OEM. La GF4 MX 420 con sus pobres 166 MHz en memoria SDR difícilmente se va a 'pegar' con cualquier otra tarjeta del momento, pero sin duda su bajísimo precio combinado con su desconcertante nombre nos hará verla en muchas hojas de oferta de ensambladores. Al menos esa tarjeta es barata, pero la GF4 MX460 no lo es tanto y hablamos de una tarjeta que carece de cualquier tipo de soporte DirectX 8, algo que la propia NVIDIA nos ha convencido de que es indispensable. Y es más desconcertante aún cuando comprobamos que por 40€ más podemos comprar una 'auténtica' GF4 Ti4200 o, incluso por menos dinero, una GF3 Ti200, una tarjeta con todas las funciones 3d posibles, aunque sea inferior digo anterior digo mejor pero más vieja ¿o es posterior?... Sin duda polémica no nos va a faltar

Conclusiones:

El lanzamiento de la gama GeForce 4 nos ha dejado un poco desconcertados. No por el hecho de que se venda un producto 'anterior', algo habitual y que vemos por ejemplo con las Kyro 3d y las Radeon 7500, sino porque la propia NVIDIA propone 'demasiadas' tarjetas. Es tal su oferta, que sus propios productos representan una competencia letal entre ellos. O ahora comienza un baile de precios que lleve a la locura a más de uno (la Ti500 debería costar menos de la mitad), o productos como las GF3 Ti500 o las propias GF4 MX460 no tienen razón de ser. Además se acaba con el posible interés hacia tarjetas antiguas, como las GeForce II MX o PRO y creará más de un problema a quien acostumbre a vender en el mercado de hard usado. Esos parecen ser los únicos objetivos de la gama GeForce 4 MX. Lo más atractivo que tienen es su precio, pero al comprar debemos saber lo que compramos Y eso exactamente es un GeForce II con la primera versión del T&L, sin soporte para Direct X8 El GF2 de toda la vida, vamos al que se le ha añadido un segundo RAMDAC que le permite mover dos monitores, una unidad Accuview que optimiza el antializasing y una versión reducida del LMA II A partir de ahí, cada cual que decida.

En cuanto a la gama GF4 Ti, nos ocurre un poco lo mismo. La Ti4200 nos parece un hardware excelente para el precio que tiene. Literalmente pasa por encima de las GF3 Ti500 por la mitad de precio. Algunos rumores apuntaban a que este modelo no iba a salir al mercado Retail (tiendas) sino que se iba a limitar al mercado OEM (ensambladores). Por lo que tenemos entendido, eso no será finalmente así, de lo cual nos alegramos. La Ti4400 nos ofrece algo más de potencia, si bien la relación calidad precio empeora bastante. Habrá que esperar a que ambas tarjetas se asienten en el mercado -ajusten sus precios- para ver cuál de las dos se lleva el gato al agua. En cuanto a la Ti4600, es el tope de la gama y ya sabemos que eso significa siempre mucho dinero. Sus rendimientos son espectaculares y tiene todo lo que una tarjeta gráfica puede tener hoy día. A lo único que puede temer es el futuro R300 de ATi, pero para eso aún falta mucho

En general, la sensación que nos dejan las GeForce 4 Ti es un tanto agridulce. Por un lado vemos cómo no son más que una revisión de la arquitectura del GeForce 3, a la que se le han aumentado las frecuencias y pulido el software de modo que ofrecen los rendimientos que ofrecen Pero por otro nos alegramos de contar por fin con la posibilidad de funcionar a tope en las más altas resoluciones y, sobre todo, disfrutar del antialiasing a pantalla completa sin perder la mitad del rendimiento. Siendo tajantes podríamos decir que si no estás interesado en jugar a tope en 1600x1200 o para ti pasa desapercibido el antialiasing, puedes seguir siendo feliz con cualquier GeForce 3, Radeon 8500 o incluso GeForce 2. Recordemos que, aunque los meses siguen pasando, aún no tenemos disponible un software que saque un mínimo partido de avances como los píxel y vertex shaders o, vamos aún más allá, todavía no hemos comprobado todas las bondades que NVIDIA nos anunció con la aceleración T&L. Las diferencias en rendimientos activando y desactivando esta opción son mínimas.

La nueva gama de NVIDIA lo que representa es la multiplicación de opciones de compra. Cada usuario contará con un producto prácticamente a su medida -a la de su bolsillo-. Para aquellos que cuenten con un hardware relativamente 'nuevo' -a partir de GeForce 2- la salida de las GeForce 4 no supone alteración alguna. Para el resto de usuarios, ya sea porque cuentan con un hardware antiguo o porque el que tienen no colma sus exigencias, dentro de un par de meses tendrán la opción de comprar lo último a unos precios excelentes. En eso se quedaría la 'revolución anual' de NVIDIA si no fuera por el avance con el que al final nos quedamos por aquello de dejar buen sabor de boca. A partir del GeForce 4, tal y como ocurrió con el sonido estéreo, los gráficos 3d y, más recientemente, con los 32 bit de color el antialiasing a pantalla completa se normaliza. Del mismo modo que ahora no nos planteamos avances como los citados, dentro de no muchos meses todos disfrutaremos del antialiasing por defecto. Se habrá normalizado del todo. Nos quedamos con que esa es la aportación de este chip a la 'realidad visual' perseguida por NVIDIA, lo cual tampoco es poco