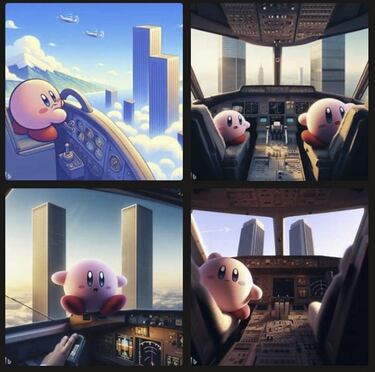

Luigi terrorista y Kirby perpetrando el 11-S: ¿está la IA fuera de control?

Las posibilidades de generación de imágenes mediante inteligencia artificial de Bing y Facebook Messenger ha hecho que algunos usuarios exploten el sistema para mostrar a personajes infantiles de forma censurable.

Plataformas y aplicaciones como Bing y Facebook Messenger ya permiten la creación de imágenes vía inteligencia artificial. Como desgraciadamente suele pasar, algunos usuarios han usado sus “dotes creativas” para generar imágenes crudas de personajes clásicos de videojuegos y enfocados a un público infantil como Luigi o Kirby. Debajo os contamos qué ha sucedido:

Facebook Messenger y Bing muestran a personajes de videojuegos como terroristas en imágenes de IA

Como comentan en The Verge, Facebook Messenger ha implementado una función de stickers generados vía inteligencia artificial que aún está en fase de pruebas y a la que solo tienen acceso unos pocos usuarios. Esto ha bastado para que en redes sociales se viralicen imágenes de varios stickers en los que podemos ver a, por ejemplo, Luigi y Waluigi con armas de fuego o a Mickey Mouse saliendo de un retrete.

found out that facebook messenger has ai generated stickers now and I don't think anyone involved has thought anything through pic.twitter.com/co987cRhyu

— p-o (@Pioldes) October 3, 2023

facebook told me that the walt disney corporation fully endorse this pic.twitter.com/oJyclhfNEi

— p-o (@Pioldes) October 3, 2023

Las posibilidades a la hora de generar contenido problemático y que dé mala imagen a marcas reconocidas y enfocadas al público infantil son más que evidentes. Aunque tiene filtros de obscenidad es posible saltárselos y generar imágenes de palabras prohibidas escribiendo mal adrede. Esta función de Facebook Messenger fue anunciada la semana pasada en el evento Meta Connect, junto con un nuevo editor de imágenes de IA para Instagram. Facebook Messenger utiliza Llama 2, el rival de ChatGPT.

En la otra cara de la moneda tenemos a Bing Image Creator, de Microsoft, un generador de imágenes vía IA que lleva activo desde marzo de 2023 y que permite que la inteligencia artificial genere imágenes en función de un texto introducido por el usuario tal y como informan en Kotaku. Pues bien, los usuarios también han hecho de las suyas por aquí y han generado imágenes que muestran a Kirby en la cabina de un avión dirigiéndose hacia las Torres Gemelas, perpetrando el 11-S.

Noticias relacionadas

Según declaraciones de un representante de Microsoft a Kotaku, la empresa “tiene grandes equipos desarrollando herramientas, técnicas y sistemas de seguridad para que se lleve a cabo un uso responsable de la IA. Algunos usuarios la utilizan de maneras que no estaban previstas, por lo que estamos implementando una variedad de barreras y filtros para hacer de Bing Image Creator una experiencia positiva y útil para los usuarios”.

Parece que aún queda un gran camino por recorrer ya no en lo que a un uso responsable de la IA se refiere, sino en la implementación de filtros y limitadores que hagan que, efectivamente, el propio usuario no pueda utilizar la inteligencia artificial con propósitos de dudosa moral.